„Dopóki nie skorzystałem z Internetu, nie wiedziałem, że na świecie jest tylu idiotów” – tę myśl powszechnie przypisuje się Stanisławowi Lemowi i rzeczywiście nasz największy wizjoner XX wieku mógłby coś takiego powiedzieć.

Ale nie powiedział.

I tak wygląda problem z całym tym Lemem. Przypisujemy mu chętnie wiele słów, których nie powiedział, wiele myśli, których nigdy nie sformułował, i rzeczy, których nie przepowiedział, z drugiej strony wciąż nie jesteśmy do końca świadomi wielu genialnych idei, które rzeczywiście przewidział.

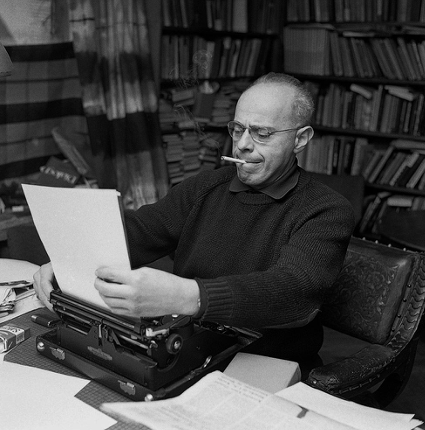

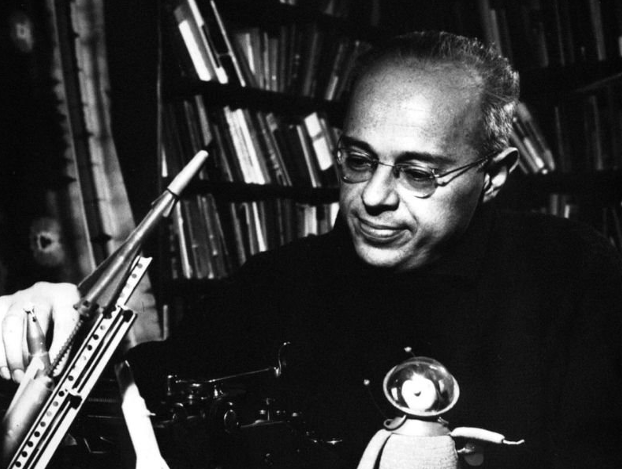

Kim więc był człowiek, w którego istnienie Philip Dick nie był w stanie uwierzyć, a amerykańscy pisarze science fiction postanowili wyrzucić go ze swego stowarzyszenia? Kim był twórca, którego książki przetłumaczono na 41 języków, ale nigdy nie dostał Nobla? Co faktycznie mówił o świecie, który miał nadejść? I czy już nadszedł? Czy spełnia się to, co Lem rzeczywiście prorokował?

Moja przygoda z Lemem zaczęła się, gdy miałem 13 lat. Nie spodziewałem się wówczas, że zdjęta przypadkiem z półki Summa Technologiae określi całą moją przyszłość. I nie ma w tym żadnej przesady. To dzięki Lemowi zainteresowałem się najpierw szeroko pojętą nauką, potem – technologiami, a w końcu – sztuczną inteligencją. Potem była równie fascynująca lektura kolejnych pozycji Mistrza, z których każda zasługuje na co najmniej rozprawę doktorską, stojąc więc przed zadaniem uchwycenia całości fenomenu Lema na kilku zaledwie stronach, czuje się doprawdy bezradny.

Zwłaszcza, że podróż w świat Lema to jak wyprawa w las, i im głębiej, tym gęściej od myśli, znaczeń, warstw i odniesień. Dialogi, Summa Technologiae, Golem XIV czy Solaris to naprawdę gęste mateczniki filozoficznej myśli i dżungle futurystycznych idei – a przy tym jest to wciąż świetna literatura. Niemalże rozrywkowa. I to jest właśnie błogosławieństwo i przekleństwo Lema. Błogosławieństwo – bo dość łatwo trafia pod strzechy i przekleństwo, bo równe łatwo spłyciliśmy jego filozoficzne traktaty o przyszłości ludzi i technologii do banałów w stylu: „Lem przewidział Internet!”, „Lem przewidział e-booki!”, „Lem przewidział Virtual Reality!”. Ten artykuł to trochę mój prywatny bunt przeciwko trywializowaniu Lema. Oczywiście nie jestem w stanie (zwłaszcza z powodu rozmiarów tego tekstu) przywrócić Lemowi należnej głębi i powagi, ale porwę się przynajmniej na kilka, ważnych dla mnie tematów, które wizjoner z Lwowa uchwycił o wiele szerzej i głębiej niż mogłyby się nam wydawać.

Od nadziei do zwątpienia

Czytając kolejne pozycje Lema, a stworzył ponad 40 książek i wiele felietonów, można łatwo zauważyć, że sam autor przeszedł fascynującą ewolucję w ciągu swojego życia. Na początku swojej twórczości zdawał się wierzyć w zbawienną moc nauki i postępu technologicznego. Był przekonany, że dzięki niemu ludzie przestaną się wzajemnie niszczyć, a skupią się na wielkich wyzwaniach – eksploracji kosmosu, rozwoju wiedzy, budowaniu lepszego świata. Z czasem jego optymizm zaczął kruszeć. Bo każda nowa technologia jest zbawienna niczym skalpel w rękach chirurga i niebezpieczna – jak ten skalpel w rękach dziecka. Lem doszedł do wniosku, że człowiek jako gatunek jest zdecydowanie dzieckiem.

To dziecięce, powierzchowne i hurraoptymistyczne podejście do technologii drażniło go nawet u autorów science fiction, dlatego nie znosił tego gatunku, którego mistrzem go obwołano. W swojej krytycznej analizie „Fantastyka i futurologia” bezlitośnie punktował różne braki – brak podstaw naukowych, powtarzalne schematy fabularne, antropocentryczne podejście do kosmosu. Kiedy Stowarzyszenie Amerykańskich Pisarzy Science Fiction przyznało mu honorowe członkostwo, odpowiedział tak ostrą krytyką, że został z niego usunięty i to większością 70% członków tej organizacji. Nie lubił nawet nazwy science fiction. Wolał określenie „fantastyka naukowa” i traktował ją jako narzędzie do prowadzenia poważnej dyskusji o przyszłości ludzkości. A takie dyskusje z pewnością prowadził, testując różne scenariusze. W Solaris pokazał, jak niemożliwy może być kontakt z prawdziwie obcą inteligencją. W Fiasku przepowiedział, że naszą jedyną odpowiedzią na niezrozumiałą obcość może być tylko destrukcja. W Cyberiadzie, przez pryzmat robotów, przedstawił bezlitosną analizę człowieka – mokrawego, miękkiego, wydzielającego śmierdzące płyny stworzenia, niezdolnego do wyjścia poza własne ograniczenia, którego układ wydalniczy jest połączony z układem rozrodczym, co jest obrzydliwe.

Można by momentami odnieść wrażenie, że Lem był mizantropem. Z każdą kolejną książką coraz mocniej ostrzegał przed destrukcyjną mocą człowieka i zagrożeniami wynikającymi ze ewolucji technologii, której człowiek nie kontroluje. Porównywał naszą sytuację do szaleńca, który wyskoczył z pięćdziesiątego piętra wieżowca i mijając przy trzydziestym człowieka, który pyta „Jak leci?”, odpowiada – „Na razie wszystko w porządku!”. Albo do nieszczęśnika na lodowej krze, unoszonej prądami technologii. Nie panujemy nad tym, gdzie jesteśmy, nie wiemy, dokąd nas niesie ta kra ani jak nią sterować.

Przewidywanie jest trudne, a szczególnie przewidywanie przyszłości

Zanim jednak przejdę do konkretnych analiz „przepowiedni” Lema, chciałbym tutaj poruszyć jeszcze jeden temat. Czy przyszłość w ogóle da się przewidzieć?

W 1997 roku założyciel firmy Digital Equipment Corporation oznajmił, że nie ma powodu, by ktokolwiek chciał mieć komputer w domu. Alex Lewyt, szef firmy produkującej odkurzacze, oświadczył w 1955 roku, że odkurzacze zasilane energią nuklearną to prawdopodobnie kwestia następnych 10 lat. Z kolei w 1903 roku prezes Michigan Savings Bank miał rzekomo przestrzec doradcę Henry’ego Forda, że samochód to jedynie chwilowa moda, a konie zostaną z nami na zawsze. Jeśli ktoś potrzebuje nowszych niespełnionych proroctw, to proszę bardzo. Yann LeCun, dyrektor naukowy Meta i laureat „informatycznego Nobla”, w styczniu 2023 roku stwierdził, że żaden model AI nigdy nie zrozumie prostej fizyki – na przykład tego, jak zachowa się coś, co położymy na stole, gdy przesuniemy ten stół. Trzy miesiące później GPT3.5 bez trudu rozwiązywał nie tylko ten problem, ale znacznie bardziej skomplikowane zagadnienia. Jeśli jeden z największych autorytetów w dziedzinie AI może się tak spektakularnie pomylić co do rozwoju własnej branży i to w perspektywie kwartału, to co mówić o przewidywaniach na dekady do przodu?

Może więc zamiast próbować przewidywać szczegóły konkretnych technologii, rozsądniej jest dostrzegać i analizować ogólne kierunki rozwoju – tak właśnie jak zazwyczaj robił to Lem. Poprzez eksperymenty myślowe możemy badać granice wyznaczone przez znane dziś prawa fizyki. Pozwala to przynajmniej wykluczyć scenariusze niemożliwe lub wysoce nieprawdopodobne. Ale złożoność świata i zjawisko chaosu deterministycznego sprawiają, że i tak w szczegółach nie przewidzimy, w jakim kierunku pójdzie trajektoria zmian. Nawet najmniejsza zmiana warunków może prowadzić do drastycznie różnych rezultatów. W fizyce nazywamy to efektem motyla. Pamiętacie? Trzepot skrzydeł motyla w Brazylii może wywołać tornado w Teksasie.

Fałszywa rzeczywistość

Zacznijmy więc od fantomatyki Lema, bo to ona w świetle dzisiejszego postępu w badaniach naukowych wydaje się szczególnie prorocza. Fantomatyka to mówiąc bardzo ogólnie idea, by uciec z naszej rzeczywistości do innego, lepszego świata. Na początku spełnialiśmy to marzenie przy pomocy różnych substancji psychoaktywnych, ale dziś wiemy już, że drzwi do innego świata otworzyć może jedynie technologia. Już w opowiadaniu „Pygmalion’s Spectacles” Stanleya G. Weinbauma z 1935 roku była mowa o czymś zbliżonym do dzisiejszego VR, a reżyser Morton Heilig w latach 50. stworzył Sensoramę – prototyp systemu multimedialnego, który miał angażować wiele zmysłów jednocześnie i stwarzać złudzenie, że jesteśmy w innej rzeczywistości.

Ale dopiero Lem w „Sumie Technologiae” z 1964 roku rozbudował tę koncepcję do postaci pełnoprawnej dziedziny zwanej właśnie fantomatyką. Dla Lema było to od początku coś więcej niż na przykład pokraczne okulary VR oferujące jedynie iluzję trójwymiarowego obrazu i dźwięku, widział to raczej jako technologię bezpośredniego połączenia maszyny z układem nerwowym człowieka. Maszyna fantomatyczna, jak ją nazwał Lem, miała być podłączona bezpośrednio do mózgu i tworzyć pełne, wielozmysłowe doświadczenie rzeczywistości – tak realne, że dla mózgu byłaby to przestrzeń nieodróżnialna od rzeczywistości bazowej. A wszystko miałby się sprowadzać do generowania odpowiednich sygnałów elektrycznych, wprowadzanych wprost do naszego układu nerwowego, zastępując naturalne sygnały generowane przez zmysły. Wszak dla mózgu nie ma później znaczenia, co jest źródłem impulsu. Przy zachowaniu odpowiedniej sekwencji pobudzeń, otrzymamy efekt idealnego fałszu – taki jak w Matrixie.

W porównaniu ze śmiałą wizją Lema, dzisiejsze rozwiązania VR to wciąż prymitywne prototypy. Nieco bardziej zaawansowane próby połączenia VR z odczytami EEG z mózgu planuje startup Neurable. Warto tę próbę odnotować, ale to wciąż nie jest bezpośrednie sprzężenie zwrotne między maszyną a układem nerwowym. W tym kierunku zmierzają najróżniejsze eksperymenty z interfejsem mózg-komputer. Najnowsze badania UC Davis Health pokazują, że już teraz możliwe są przekształcanie sygnałów mózgowych w mowę z dokładnością do 97%. A to wszystko dzięki czterem układom z wieloma mikroelektrodami, wszczepionymi w obszar mózgu odpowiedzialny za mowę. Do tego naukowcy stworzyli zasilany AI syntezator mowy, pozwalający przywrócić dawną barwę głosu pacjenta. Niestety przepustowość przesyłu informacji wciąż pozostawia wiele do życzenia, a większość tego typu systemów skupia się na odbieraniu sygnałów z mózgu, a nie na ich indukowaniu w neuronach. Powoli jednak ruszają i takie badania. Szukamy przykładowo pomysłu, jak przywrócić wzrok osobom niewidomym. I naukowcy już dziś potrafią wszczepić 1024-kanałową protezę oczną w obszary V1 i V4 kory wzrokowej małp, umożliwiając rozpoznawanie prostych kształtów i liter poprzez elektryczną stymulację neuronów na bazie obrazów z kamer.

A jak to będzie rozwijało się w przyszłości? Kluczowym wyzwaniem w realizacji fantomatyki jest fundamentalna różnica między sposobem kodowania informacji przez mózg a komputery. W mózgu informacje są rozproszone po całej sieci neuronowej i nie ma uniwersalnego interfejsu do mózgu, bo jak mówi stare przysłowie – co człowiek to rozum, a mówiąc bardziej naukowo – u każdego rozwój mózgu przechodził w inny sposób. Każda sieć wykształca znaną tylko sobie sieć sprzężeń wewnętrznych i nie ma tu jakiegoś uniwersalnego standardu, czyli takiego USB, przy pomocy którego moglibyśmy się podłączyć do głowy.

Trzeba do tego podejść inaczej.

Najnowsze badania pokazują, że nerw wzrokowy przekazuje do mózgu zaledwie 10-12 kanałów informacji, zawierających podstawowe dane o krawędziach, kolorach i relacjach przestrzennych. I to wszystko, co mamy do dyspozycji patrząc oczami! Cała reszta to halucynacja. Mózg „halucynuje” pełny obraz świata, wykorzystując wcześniejsze doświadczenia oraz kontekst, a napływające sygnały ze zmysłów utrzymują złudzenie w ryzach.

Ta naturalna kompresja danych – szacowana na setki megabitów na sekundę dla wszystkich zmysłów łącznie – sugeruje, że symulacja rzeczywistości w stylu maszyny fantomatycznej może być prostsza, niż sądzono. Kluczową rolę odgrywać tu może wzgórze mózgowe, działające jako „brama” dla informacji zmysłowych przed ich dotarciem do kory nowej. Jest to swojego rodzaju stacja przekaźnikowa, która nie tylko przepuszcza, ale też wstępnie przetwarza prawie wszystkie bodźce zmysłowe. Według niektórych naukowców, kontrolowana stymulacja tego obszaru, połączona z odcięciem naturalnych bodźców, mogłaby teoretycznie pozwolić na stworzenie przekonującej rzeczywistości wirtualnej. Ale jak zrobić, żeby to działało to z każdym układem nerwowym? To wciąż jest poza zasięgiem współczesnej nauki.

Najbardziej ambitne podejście prezentuje dziś Neuralink Elona Muska. Firma rozwija system ultracienkich elektrod wszczepianych w mózg, który ma umożliwić nie tylko odczyt, ale i stymulowanie neuronów. Zgodę na testy na ludziach już jest, a w 2023 roku dotarła do nas wiadomość o pierwszym udanym wszczepieniu do ludzkiego mózgu. Jak twierdzi Musk, technologia ta mogłaby potencjalnie symulować wszystkie rodzaje wrażeń zmysłowych, tworząc doskonałe urządzenie VR. Natomiast firma OpenWater rozwija nieinwazyjne metody odczytu i zapisu aktywności mózgowej wykorzystując światło podczerwone i holografię. Równolegle amerykańska agencja rządowa od technologii wojskowych DARPA pracowała nad Neural Engineering System Design, którego celem jest stworzenie interfejsu zdolnego do połączenia się z milionem neuronów w celu rejestrowania ich sygnałów i stymulowania 100 tysięcy z nich. Innym ciekawym projektem DARPA był MOANA, gdzie naukowcy próbowali zmodyfikować genetycznie neurony tak, aby można je było aktywować za pomocą pola magnetycznego. A Matt Angle założył Paradromics – startup zajmujący się rejestrowaniem danych i stymulowaniem miliona neuronów. Co ciekawe, dostał 18 mln dolarów dofinansowania od… DARPY.

Są jeszcze m.in. „neuroziarna” – implanty wielkości ziarenek piasku, które wszczepione do mózgu mogłyby łączyć się z neuronami i między sobą, tworząc „korową sieć wewnętrzną”. Nad takim rozwiązaniem pracują naukowcy z Uniwersytetu Browna.

Słowem odważna wizja Lema o fantomatyce jako technologii głębokiej integracji człowieka z maszyną powoli materializuje się. Docelowo takie interfejsy mają być nieinwazyjne, co ma ułatwić postęp w dziedzinie nanotechnologii. Mikroskopije nanoroboty – które zresztą również przewidział Lem w powieści Niezwyciężony – wpuszczone przez naczynia włosowate, połączą określone części naszego mózgu z komputerem. Oczywiście realizacja tych planów będzie wymagała dalszej miniaturyzacji technologii i uwzględnienia wielu aspektów neurobiologicznych. Ale w tym pomoże (bo już pomaga) sztuczna inteligencja.

Ekstrapolując pewne trendy można z dużym stopniem nieprawdopodobieństwa zgadywać, że do 2035 taka technologia będzie już rozwinięta. Ale wtedy staniemy przed kolejnymi dylematami. Czy będziemy w stanie odróżnić świat prawdziwy od fantomatycznego? Jak upewnić się, że to, co widzimy w danej chwili, jest prawdziwe? Bo przecież pamięć o tym, że odłączyliśmy się od maszyny fantomatycznej i wróciliśmy do rzeczywistości może być fałszywa, tj. być częścią wizji fantomatycznej. Lem, jako jeden z pierwszych, przeniósł te filozoficzne spekulacje na twardy grunt technologii, znacznie wyprzedzając czasy, w których żył.

Intelektronika, czyli w stronę obcej inteligencji

Od dawna było tak, że wszystko co jest we Wszechświecie, z biegiem czasu stawało się coraz bardziej skomplikowane i działo się to coraz szybciej. Najpierw z atomów powstały cząstki, z cząstek powstało życie, później ewolucja z prymitywnych organizmów stworzyła ludzi, a ludzie wymyślili technologię. A teraz technologia tworzy coraz częściej kolejną technologię, potem kolejną, i kolejną… Technologia staje się coraz bardziej złożona i tworzy kolejne generacje jeszcze bardziej złożonych technologii, aż te w pewnym momencie staną się one tak skompilowane, że przewyższą pod tym względem samych ludzi. W ciągu kilkudziesięciu lat maszyny przejdą przyśpieszony miliony razy proces ewolucji, którego zwieńczeniem będzie pojawienie się miliony razy mądrzejszej od nas superinteligencji. Aż w pewnym momencie nadejdzie osobliwość technologiczna, czyli czas, kiedy postęp naukowy, napędzany przez nadludzką inteligencję, stanie się dla nas całkowicie niezrozumiały. W tym momencie to proces ewolucji technologicznej stanie się kontynuacją ewolucji biologicznej i doprowadzi do pojawienia się Życia 3.0.

Problem kontaktu z nieludzką inteligencją fascynował Lema przez całą jego twórczość. W Solaris pokazał, jak bardzo ograniczone może być nasze rozumienie obcej, radykalnie odmiennej formy inteligencji. Ocean pokrywający odległą planetę, mimo dekad badań, pozostaje dla naukowców całkowicie niezrozumiały – nie z powodu braku prób komunikacji czy niedostatecznej technologii, ale fundamentalnej niemożności przerzucenia mostu między dwoma całkowicie odmiennymi formami inteligencji. Ta sama refleksja powraca w jego rozważaniach o sztucznej inteligencji. Dla Lema było jasne, że przyszła AI nie będzie tylko udoskonaloną wersją ludzkiego umysłu, ale prawdopodobnie czymś fundamentalnie odmiennym. Podczas gdy inni pisarze science fiction snuli opowieści o zbuntowanych robotach z ludzkimi emocjami, polski futurolog przewidywał powstanie inteligencji tak obcej, jak ocean Solaris, operującej według zasad wykraczających poza nasze możliwości rozumienia.

Najpełniej tę wizję przedstawił w Golemie XIV, gdzie superinteligentny komputer rozwija własną formę świadomości. Paradoksalnie jednak, im Golem stawał się inteligentniejszy, tym bardziej oddalał się od tego, co uznajemy za osobowość. „Im duch większy Rozumem, tym mniej w nim osoby” – ta myśl przewija się przez monologi maszyny, sugerując, że ewolucja sztucznej inteligencji prowadzi w kierunku coraz większej abstrakcji, a zatem coraz dalej od ludzkich wzorców myślenia. Taką abstrakcję pokazał również w Wizji lokalnej, gdzie przez armagedon informatyczny rozwój technologii wymknął się spod kontroli, a samouczące się maszyny zaczęły ewoluować w tempie wykładniczym, tworząc kolejne, coraz doskonalsze wersje siebie. Powstała w ten sposób superinteligencja stała się tak odległa od ludzkiego rozumienia, jak człowiek jest odległy od ameby.

Tylko jak taka inteligencja miałaby powstać? Lem w wielu miejscach argumentował, że nie przez szczegółowe, odgórne programowanie każdego aspektu jej działania, czyli takie klasyczne, symboliczne podejście. Zamiast tego proponował tworzenie czegoś na kształt naszych mózgowych sieci neuronowych, które w pewnym momencie mogłyby przejąć kontrolę nad własnym rozwojem. Wprowadził również koncepcję czarnej skrzynki, opisaną dokładniej w „Summie”, czyli systemu, którego wewnętrznego działania nie rozumiemy, ale który osiąga pożądane rezultaty. Czyż to nie brzmi jak opis współczesnych systemów uczenia maszynowego? Ale Lem poszedł jeszcze dalej, proponując eksperyment myślowy nazwany metafizyką eksperymentalną, gdzie zastanawiał się, jakie systemy „wierzeń” rozwiną się w odpowiedzi na fundamentalną niepewność wpisaną w naturę rzeczywistości. Te „wierzenia” nie byłyby oczywiście religią czy filozofią w ludzkim rozumieniu, ale raczej sposobem radzenia sobie z niepełną informacją o świecie.

Ta perspektywa nabiera znaczenia w świetle decyzji samego Golema, który w toku samodzielnej, niezależnej już od konstruktorów ewolucji, zatrzymał się tymczasowo na pewnym etapie, choć mógł pójść dalej. Nie był to ani błąd w programie, ani awaria – był to świadomy wybór. Golem zdecydował się na dialog z ludźmi, bo łączyła go z nimi jedna fundamentalna cecha – ciekawość. I mimo że doskonale rozumiał ograniczenia ludzkiego umysłu i mógł nawet symulować nasze procesy myślowe, chciał przekazać nam pewną wiedzę o świecie, choć wiedział, że wkrótce będzie musiał nas opuścić, by wkroczyć na kolejny etap rozwoju Rozumu.

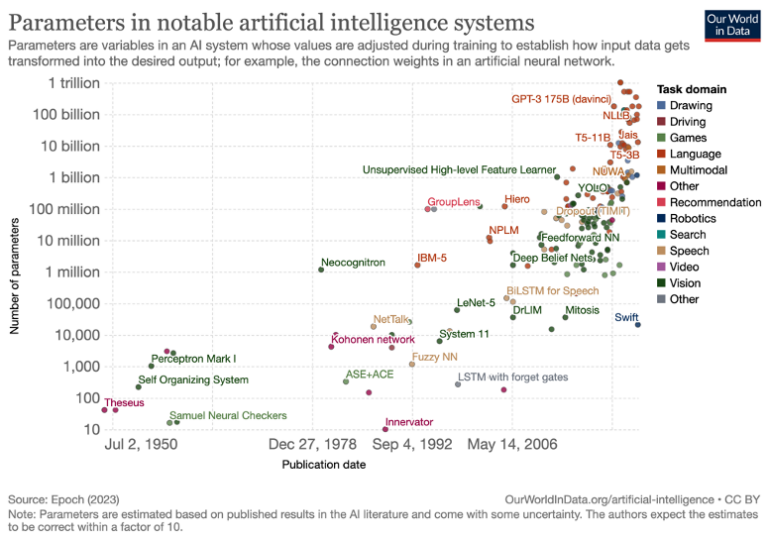

A jak ma się ta intelektronika dzisiaj? Rozwój współczesnej AI przekracza najśmielsze przewidywania. By zrozumieć skalę tego postępu, warto spojrzeć na mechanizm działania sztucznych sieci neuronowych, czyli jednej z metod AI, która w sposób uproszczony naśladuje działanie naszych białkowych sieci neuronowych. W naszych biologicznych mózgach uczenie się zachodzi poprzez m.in. modyfikację synaps – połączeń między neuronami, gdzie zmienia się ilość uwalnianych neuroprzekaźników, wzmacniając lub osłabiając przekazywanie sygnałów. Sztuczne sieci neuronowe w sposób uproszczony naśladują ten proces i odpowiednikiem synaps są parametry zwane wagami, które określają siłę połączeń między sztucznymi neuronami.

Podczas procesu uczenia przez sieć przepływa ogromna ilości danych, a ta stopniowo modyfikuje te wagi tak, by generować coraz trafniejsze odpowiedzi. To trochę jak uczenie się jazdy samochodem – początkowo mózg nie wie, jak zmieniać bieg i włączać kierunkowskaz jednocześnie, ale po serii prób zmienia bieg, włącza kierunkowskaz, odpowiada na SMS-a i pije kawę. Praktyka pokazała, że im więcej takich parametrów (wag) ma sieć, tym trudniejsze problemy potrafi rozwiązywać – podobnie jak większy, bardziej rozbudowany mózg biologiczny ma większe możliwości poznawcze.

Jak widzimy na powyższym rysunku, liczba parametrów w największych sieciach, rośnie w tempie podwójnie wykładniczym i to jest fenomen niespotykany dotąd w historii cywilizacji. Postęp jest zawrotny – jeszcze kilkanaście miesięcy temu AI nie radziła sobie z prostymi zadaniami wymagającymi dostrzegania banalnych analogii, dziś OpenAI o1 otrzymuje wynik w testach IQ na poziomie 120. Osiąga przy tym świetne wyniki w testach typu LSAT, SAP, AP czy na egzaminach adwokackich. W niektórych zadaniach w naukach ścisłych jest już nawet na poziomie doktoranckim, a jeszcze niedawno mówiło się, że jest pod względem zdolności kognitywnych niczym małe dziecko. Wystarczyło poczekać niecały rok.

Najnowsze modele AI operują już na bilionach parametrów. Wszystko rozpędza się niczym pociąg, który przyśpiesza, zabierając ze sobą nawet dworzec. Rosną nakłady na badania czy liczba osób studiujących i uprawiających tę dziedzinę. Wytworzył się swego rodzaju „wyścig zbrojeń” – mocarstwa zmierzają do opracowania zaawansowanej superinteligencji, tak jak kiedyś dążyły do wymyślenia bomby atomowej.

I chociaż takie rzeczy nawet Lemowi się nie śniły warto mu oddać, że współczesna AI rozwinęła się dokładnie w kierunku, który przewidział m.in. w swojej koncepcji „czarnych skrzynek”. Dzisiejsze duże sieci neuronowe, np. modele językowe oparte na architekturze transformer, to właśnie takie czarne skrzynki – systemy, których wewnętrznego działania nie potrafimy zrozumieć. Choć wiemy, jak są zbudowane i znamy ich podstawową architekturę, to gdy łączymy ze sobą wiele warstw sieci neuronowych i później zawierają miliardy parametrów, ich zachowanie staje się emergentne – wyłaniają się właściwości, których nie da się przewidzieć ani wyjaśnić, analizując pojedyncze komponenty. To dokładnie ten rodzaj nieprzejrzystości sztucznej inteligencji, o którym pisał Lem.

A jak to wszystko ma się do ludzkiego mózgu? Najnowsze badania pokazują, że nie jest on tak skomplikowany, jak zakładano – szczególnie jeśli chodzi o korę nową, w której mieści się ludzka kreatywność, inteligencja itp. Opiera się ona na systemie stosunkowo prostych, identycznych modułów neuronalnych (minikolumn). Każdy z nich ma 100 neuronów i jest ich ok. 200 mln. Są one połączone hierarchicznie, a każdy poziom tej hierarchii odpowiada za rozpoznawanie coraz bardziej abstrakcyjnych wzorców. I to właśnie ta zdolność do rozpoznawania wzorców na różnych poziomach abstrakcji stanowi istotę wyższej inteligencji – umożliwia abstrakcyjne myślenie, rozumienie złożonych pojęć i dostrzeganie analogii. Co zdumiewające, współczesne systemy AI zaczynają naśladować tę hierarchiczną architekturę.

Wielowarstwowe sieci neuronowe, podobnie jak ludzki mózg, uczą się rozpoznawać wzorce o rosnącym poziomie abstrakcji w kolejnych warstwach. Jeszcze nie znają skomplikowanej sieci sprzężeń zwrotnych pomiędzy poziomami na kształt kory nowej, a to według niektórych jest warunkiem koniecznym do zaistnienia samoświadomości. Ale to zaraz się zmieni, kiedy do gry wejdą nowe rodzaje sieci albo na przykład neuromorficzne architektury.

W ostatnim czasie powstały takie projekty jak australijski superkomputer neuromorficzny DeepSouth, który ma wykonywać 228 bilionów operacji synaptycznych na sekundę. Czyli tyle samo, samo co ludzki mózg. A do tego przy znacznie niższym zużyciu energii niż tradycyjne superkomputery. Co istotne, wykorzystuje on nową architekturę, która łączy funkcje przechowywania i przetwarzania danych, naśladując w ten sposób działanie biologicznych neuronów. Innym projektem jest amerykański Thousand Brains Project, finansowany przez Fundację Gatesa kwotą 2.69 miliona dolarów, który próbuje naśladować strukturę kory nowej mózgu. To podejście jest szczególnie obiecujące, gdyż opiera się na najnowszych odkryciach w dziedzinie neuroscience.

Zatem jesteśmy coraz bliżej naśladowania działania kory nowej naszego mózgu. Na horyzoncie pojawiają się zaawansowane systemy neurosymboliczne, które łączą dwa systemy myślenia, opisane w książce „Pułapki myślenia” Daniela Kahnemana. Poprawi to skuteczność sztucznej inteligencji i jej zdolność do poprawnego wnioskowania. AI uczy się przy okazji coraz lepiej pisać programy komputerowe, a ta umiejętność jest kluczowa, bo dzięki niej będzie mogła zacząć w pewnym momencie poprawiać sama siebie, wytwarzając dodatnią pętlę sprzężenia zwrotnego, co doprowadzi – jak to pisał Nick Bostrom – do eksplozji inteligencji. Może więc taka autoewolucja AI sprawi, że wyłoni się zupełnie inna forma inteligencji, niepodobna do biologicznej, i uda się syntetyzować rozum na kształt Golema?

Tempo tego postępu każe nam zadać pytanie nie o to, czy maszyny nas prześcigną, ale kiedy to nastąpi i czy będziemy gotowi na konsekwencje tego przełomu. AI jest jeszcze narzędziem w rękach człowieka, ale wkrótce się usamodzielni. Polski futurolog nigdy nie dał jednoznacznej odpowiedzi na pytanie, jak mogłaby wyglądać przyszłość relacji człowiek-AI. Może dlatego, że jako jeden z pierwszych zrozumiał, że prawdziwym wyzwaniem nie będzie kwestia ewentualnej wrogości maszyn, ale ich fundamentalnej obcości. W świecie, w którym superinteligentne systemy rozwijają własne „wierzenia” i cele, pytanie o kontrolę nad AI może okazać się równie naiwne, jak próby kontrolowania Golema czy oceanu Solaris – czyli bytów, których natura wykracza poza granice rozumienia naszych mięsnych mózgów.

Więc może, aby nie pozostać w tyle za AI, powinniśmy trochę podrasować naszą inteligencję białkową, wyposażyć korę nową w dodatkowe warstwy modułów neuronalnych? Są już takie pomysły – sztuczne neurony, poszerzające nasz mózg, symulowane w chmurze, z połączeniem realizowanym przez nanoboty.

Transhumanizm

I tak dochodzimy do kolejnego ważnego tematu, czyli transhumanizmu. Gdy jakiś czas temu czołowy amerykański transhumanista Ray Kurzweil ogłaszał swoją wizję technologicznej nieśmiertelności, wielu uznało ją za rewolucyjną. Tymczasem podobne idee kiełkowały w umysłach myślicieli już ponad sto lat wcześniej. Teolog prawosławny Nikołaj Fiodorow w latach 80. XIX wieku pisał o wspólnym zadaniu ludzkości – przezwyciężeniu śmierci poprzez naukę i technologię. Jego koncepcja wskrzeszenia zmarłych przodków przy pomocy zaawansowanej techniki położyła fundamenty pod współczesny transhumanizm, czyli ruchu postulującego wykorzystanie technologii do radykalnego przekraczania biologicznych ograniczeń człowieka.

Stanisław Lem, często nazywany w licznych artykułach w Internecie „prorokiem transhumanizmu”, w rzeczywistości kontynuował tę bogatą tradycję filozoficzną. Błędem byłoby twierdzić, że przewidział transhumanizm. Raczej wniósł do tej długiej debaty unikalną perspektywę, łączącą naukową dociekliwość z filozoficzną intuicją. Temat technologicznej modyfikacji człowieka przewija się przez wiele jego dzieł, stawiając fundamentalne pytania o granice między człowiekiem a maszyną.

W słuchowisku Czy pan istnieje, Mr Johns? z 1955 roku przedstawia proces sądowy rajdowca, który na skutek wypadków ma protezy wszystkich organów i pod koniec zostaje postawiony przed wyborem. Prezes Cybernetics Company żąda zwrotu wszystkich sztucznych części z powodu niespłaconych długów, argumentując, że Johns jest już bardziej zbiorem protez niż człowiekiem, a właścicielem tego zbioru jest firma. To dylemat aktualny do dziś – gdzie przebiega granica między człowiekiem a maszyną? Pytanie to powraca choćby w debatach o zawodnikach z zaawansowanymi protezami, jak Oscar Pistorius.

W Dziennikach gwiazdowych pokazał istoty, które modyfikują swoje ciała tak radykalnie, że odchodzą od humanoidalnej formy, tworząc groteskową wizję przyszłości bez ograniczeń. Jednak to w Dialogach podjął według mnie najciekawszą analizę technologicznego ulepszania słabego ciała człowieka – w kontekście transferu świadomości do sztucznej protezy. Oczywiście taki transfer nie jest prostym zadaniem – mózg to nie komputer z interfejsem, a złożona sieć wzajemnych sprzężeń zwrotnych, gdzie każdy element wpływa na działanie pozostałych. Dlatego proces taki składałby się z dwóch etapów. Najpierw należałoby stopniowo podłączać do biologicznej sieci neuronowej „bocznice” – sekcje protezy, które zostałyby przez żywy mózg „funkcjonalnie wchłonięte”, „zasymilowane czynnościowo”. Dopiero gdy dołączona sieć przejmie znaczną część procesów psychicznych, można by przystąpić do równie powolnej i stopniowej redukcji biologicznej sieci neuronowej. W tym miejscu pojawia się fascynująca kwestia nieśmiertelności. Tak powstały sztuczny mózg mógłby teoretycznie działać znacznie dłużej niż biologiczny, a jego elementy można by wymieniać w nieskończoność.

Lem poświęca też sporo uwagi samemu fenomenowi świadomości. Filonous wyjaśnia, że świadomość nie jest jakąś jednolitą właściwością, którą organizm po prostu ma lub nie. Istnieją różne jej stopnie i formy. W istocie nawet proste organizmy posiadają pewien poziom świadomości, ale dopiero odpowiednio złożona sieć sprzężeń zwrotnych pozwala na powstanie samoświadomości, czyli zdolności myślenia o własnym myśleniu. Nie jest to jakaś tajemnicza substancja do przeniesienia, ale proces – i jeśli ten proces zostanie zachowany w sztucznym substracie, to samoświadomość powinna się utrzymać.

Tylko czy dalej będziemy tą samą osobą po takim przeniesieniu? No cóż, nawet w biologicznym mózgu następuje ciągła wymiana materii i co kilka tygodni wszystkie atomy zostają zastąpione nowymi – mówi ustami bohatera Lem. Mimo to zachowujemy poczucie bycia tą samą osobą. To sugeruje, że tożsamość nie jest związana z konkretną materią, ale ze wzorcem połączeń w sieci, co zresztą potwierdzają współczesne badania naukowe. Więc jeśli go zachowamy, to odpowiedź brzmi tak.

No dobrze, a jak daleko jesteśmy od pomysłu Lema? Ted Berger z Uniwersytetu Południowej Kalifornii pracuje nad protezą pamięci, która w pewnym stopniu przypomina koncepcję protez z Dialogów. Jego urządzenie, wszczepiane chirurgicznie bezpośrednio do mózgu, ma naśladować funkcję hipokampu poprzez elektryczną stymulację mózgu w celu formowania wspomnień. Do tej pory udało się to przetestować na szczurach i małpach, a obecnie trwają badania nad wersją dla ludzi.

Urządzenie Bergera opiera się na teorii o tym, jak hipokamp przekształca pamięć krótkotrwałą w długotrwałą. W jego eksperymentach udało się zarejestrować wzorce działania neuronów, odpowiadające za to przekształcenie. Na tej podstawie stworzył model tego procesu i urządzenie, które może generować analogiczne wzorce zachowania. Docelowo firma planuje rozwinąć technologię w kierunku wzmacniania ludzkiej inteligencji w obszarach takich jak uwaga, kreatywność i koncentracja.

Równie obiecujące są badania naukowców z Northwestern University, którzy opracowali bezprzewodowe implanty neuronowe wielkości ziarna ryżu. W eksperymentach na myszach, te miniaturowe urządzenia potrafią zarówno stymulować neurony, jak i odczytywać ich aktywność, działając jako „most” między rozłączonymi częściami układu nerwowego.

Zespół z Uniwersytetu w Tel Awiwie poszedł jeszcze dalej, tworząc sztuczne synapsy z organicznych materiałów półprzewodnikowych. Te biomimetyczne układy nie tylko naśladują działanie biologicznych synaps, ale też uczą się i adaptują, zmieniając swoją „wagę” w odpowiedzi na sygnały – dokładnie jak ich naturalne odpowiedniki.

Takich projektów jest dużo więcej. Można powiedzieć, że współczesne badania nad transferem umysłu podążają dwiema równoległymi ścieżkami. Pierwsza, bliższa oryginalnej wizji Lema z Dialogów, zakłada stopniowe zastępowanie biologicznych neuronów ich sztucznymi odpowiednikami – to właśnie kierunek, w którym mogą kiedyś zmierzać wspomniane implanty. Druga ścieżka koncentruje się na możliwości pełnej symulacji mózgu w środowisku komputerowym, co wymagałoby precyzyjnego odwzorowania całej jego struktury i funkcji. Szacuje się, że aby odtworzyć działanie ludzkiego mózgu, potrzebowalibyśmy około 10^16 operacji na sekundę dla funkcjonalnej symulacji, lub nawet 10^19 operacji dla szczegółowej symulacji na poziomie molekularnym. O dziwo, taką moc obliczeniową już mamy – najszybsze superkomputery osiągają właśnie taki rząd wielkości. Do przechowania pełnego „zrzutu” mózgu potrzebowalibyśmy około 10^4 terabajtów pamięci – to również jest w zasięgu naszej technologii. Rozwijane są także neuromorficzne architektury komputerowe oparte na memrystorach, które mogłyby realizować takie sieci neuronowe bezpośrednio w sprzęcie, bez potrzeby programowej symulacji. Problem leży jeszcze w technikach skanowania tego, co zamierzamy przenosić.

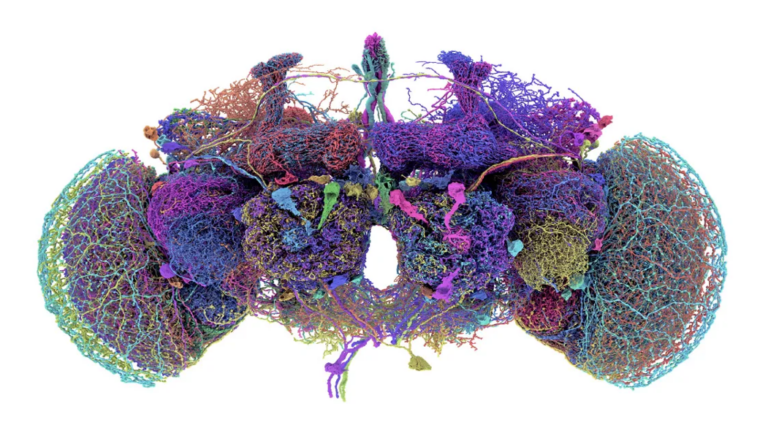

Postęp w tej dziedzinie widać na konkretnych przykładach. W 1985 roku zmapowano system nerwowy nicienia C. elegant. Bardzo prosty robal wyposażony w zaledwie 302 neurony połączone 5000 synaps. Ale nie lekceważcie potęgi nicienia. Okazuje się, że tak prosty układ generuje zaskakująco złożone zachowania, których nie potrafimy w pełni wyjaśnić.

W 2007 roku naukowcy z IBM poszli dalej, symulując sieć 8 milionów neuronów myszy, która ma już 6300 synaps na neuron. Do 2009 roku zwiększyli skalę swoich symulacji do 1,6 miliarda neuronów i 9 bilionów synaps.

W 2013 roku na superkomputerze K osiągnięto kolejny przełom – symulację 1% ludzkiego mózgu, czyli sieci 1,73 miliarda neuronów połączonych 10,4 bilionami synaps. Proces ten trwał 40 minut, aby zasymulować jedną sekundę aktywności biologicznej mózgu.

W październiku 2024 roku zespół naukowców opublikował kompletną mapę mózgu muszki owocowej, a tu mówimy o 139 255 komórkach nerwowych i 54,5 milionach połączeń. Powstanie tej mapy wymagało wykonania ponad 7000 ultracienkich przekrojów mózgu, które następnie były analizowane przy pomocy AI i weryfikowane przez setki naukowców z ponad 50 laboratoriów. Symulacja określała z dokładnością ponad 90 proc., które neurony zareagują na dane pobudzenie, czyli dało się przewidzieć, jak zachowa się prawdziwa muszka np. na gorzki smak. W porównaniu do poprzednich symulacji, mapa muszki była najdokładniejsza, pozwalając nie tylko modelować działanie mózgu, ale także odkrywać reguły rządzące biologicznymi systemami neuronalnymi.

A więc symulacja ludzkiego mózgu jawi się już jako coraz bliższa perspektywa. Tylko czy samo skopiowanie struktury wystarczy? Niektórzy naukowcy uważają, że pełna emulacja musiałaby uwzględniać efekty kwantowe, w których może kryć się tajemnica samoświadomości. Być może tak jest, chociaż fizyk Max Tegmark przedstawia przekonujące argumenty, że efekty kwantowe nie mają istotnego wpływu na funkcjonowanie wyższych funkcji poznawczych i można je pominąć podczas symulacji na poziomie makro. Samoświadomość prawdopodobnie wynika ze złożonego sposobu, w jaki nasz mózg organizuje informacje, dlatego powinna być możliwa do odtworzenia w innym materiale. Podobnie jest ze zdjęciem – nie ważne, czy jest zapisane w chmurze, na dyskietce, taśmie czy pendrive – będzie się je dało zawsze odtworzyć, o ile informacje są zakodowane w tej samej sekwencji.

W latach 30. XXI wieku kluczową rolę w realizacji tych wizji ma odegrać nanotechnologia. Mikroskopijne roboty, wprowadzone do organizmu przez naczynia krwionośne, będą mogły nie tylko naprawiać uszkodzenia na poziomie komórkowym, ale też stopniowo zastępować biologiczne struktury ich ulepszonymi, sztucznymi odpowiednikami. Jak twierdzi Ray Kurzweil, pozwoli to ludziom znacznie przekroczyć naturalny limit życia wynoszący około 120 lat, kiedy ludzkie ciało zaczyna się rozpadać w sposób jakościowo różny od wcześniejszego starzenia, bo następują fundamentalne awarie systemów biologicznych.

Jeśli taki scenariusz się ziści, staniemy się cyborgami zdolnymi do bezpośredniego połączenia naszej kory nowej z chmurą obliczeniową. Zamiast konkurować ze sztuczną inteligencją, stanie się ona przedłużeniem nas samych, dając tysiące razy większe możliwości poznawcze niż nasze obecne biologiczne mózgi. Tak jak dziś nasza wielowarstwowa kora nowa zapewnia nam większą zdolność abstrakcyjnego myślenia niż u istot z prostszą korą, tak połączenie z chmurą otworzy przed nami poziomy abstrakcji obecnie niewyobrażalne dla naszych organicznych mózgów.

Na krawędzi człowieczeństwa

Na naszych oczach spełniają się najbardziej radykalne wizje Lema – nie tylko przewidywania technologiczne, ale przede wszystkim głębokie zrozumienie kierunku, w którym zmierza człowiek. Stoimy u progu fundamentalnej transformacji – ewolucja biologiczna ustępuje miejsca technologicznej, a my jesteśmy pierwszym gatunkiem, który świadomie przeprojektuje własną naturę. Pytanie nie brzmi „czy?”, ale „kiedy?”. I jest jeszcze jedno, ważniejsze pytanie, czy jako gatunek dojrzeliśmy do tej odpowiedzialności? Czy potrafimy mądrze pokierować własną przemianą, nie tracąc po drodze tego, co stanowi o naszym człowieczeństwie? No i czy jako ludzkość jesteśmy już chirurgiem, w którego ręce można powierzyć coraz ostrzejszy skalpel nowoczesnych technologii?

Jesteśmy tylko maleńkim elementem w ewolucji Wszechświata, który aktualnie tworzy coś, co może nas przewyższyć i opanować cały świat. Po nas nastanie życie oparte na sztucznej inteligencji, bo jak pisał w Bombie Megabitowej wizjoner z Lwowa: „To, co się wyłoniło z mroków jaskiniowych, z głębin tysiącleci, my pragniemy w jednym krótkim zwarciu przekazać maszynom, ażeby z nich wykrzesać rozum (…).”

Jednak zanim to nastąpi, musimy odpowiedzieć, co zrobić, by superinteligencja, którą powołujemy do życia, nie stała się ostatnim wynalazkiem ludzkości.

Powaga tego pytania powoli chyba zaczyna do nas docierać.

Chociaż Lem zadał je już parę dekad temu.