Stworzenie sztucznej inteligencji byłoby największym wydarzeniem w historii ludzkości. Niestety, mogłoby również być ostatnim, chyba że nauczymy się panować nad związanym z tym ryzykiem.”

Te słowa zostały wypowiedziane przez genialnego brytyjskiego fizyka – Stevena Hawkinga. Mówiąc to, miał na myśli powstanie tzw. silnej sztucznej inteligencji, która posiada umysł i dorównuje lub przewyższa pod względem intelektualnym człowieka. Znamy ją dobrze z wielu filmów s-f, takich jak

Ex Machina,2001: Odyseja kosmiczna lub Terminator . I tak jak pięściak był pierwszym wynalazkiem człowieka, to taka superinteligencja mogłaby być jego ostatnim dziełem.

Silnej sztucznej inteligencji jeszcze nie mamy. Dysponujemy jej słabą wersją, czyli taką, która przydaje się do rozwiązywania wielu praktycznych, wąsko zdefiniowanych problemów. Ale nawet taka słaba sztuczna inteligencja już dawno prześcignęła człowieka w niektórych – wąskich – obszarach. Jej możliwości rosną wykładniczo, nic więc dziwnego, że niektórzy naukowcy spodziewają się, że już za kilkadziesiąt lat AI prześcignie człowieka na wszelkich polach. I będzie od nas miliony razy inteligentniejsza.

Nim jednak weźmiemy na tapet temat silnej sztucznej inteligencji i tzw. momentu osobliwości technologicznej, chciałbym zabrać Państwa w podróż po historii tej dziedziny.

Louis Gauffier: Pigmalion i Galatea

„Król Cypru” Pigmalion (…) żył samotnie, długo nie dzieląc łoża z żadną niewiastą. Tymczasem wyrzeźbił z niezwykłym kunsztem w białej kości słoniowej postać nadludzką pięknej kobiety i zakochał się w swoim dziele. (…).

Pigmalion podziwiał ją i zapłonął gwałtowną miłością do tej postaci‑ułudy. Często dotykał swego dzieła, by sprawdzić, czy jest to ciało, czy kość słoniowa (…).

Nadeszło święto bogini Afrodyty, uroczyście obchodzone na całym Cyprze (…). Pigmalion przystąpił z ofiarnym darem do ołtarza, stanął i rozpoczął nieśmiałą modlitwę: – Jeśli wy, bogowie, jesteście wszechmocni, to sprawcie, bym miał za żonę – nie ośmielił się powiedzieć dziewczynę z kości słoniowej, lecz powiedział – Dziewczynę podobną do mojej z kości słoniowej.

Ale złota Afrodyta – przybyła bowiem sama na swoje święto – poznała intencję tej modlitwy (…).

Kiedy Pigmalion wrócił do domu, pobiegł do posągu dziewczyny i kładąc się obok na łożu, zaczął ją całować. Wydało mu się, że stała się ciepła (…). Pod jego dotknięciem kość słoniowa zmiękła (…). Czuł pod palcami pulsowanie krwi w jej żyłach.

Tą kobietą, którą ożywiła Afrodyta, była Galatea. Pewnie zastanawiają się teraz Państwo, dlaczego umieszczam w tym wpisie poświęconym stricte technologii takie starocia. Już wyjaśniam! Historia ta pokazuje pewne odwieczne pragnienie człowieka. Ludzie od niepamiętnych czasów zastanawiali się, czy da się skonstruować myślącą maszynę. To zdumiewające, jak mało się różnimy pod tym względem od starożytnych Greków. My również chcemy budować takie inteligentne „rzeźby”: rozwijamy sztuczną inteligencję i łączymy ją z mechanicznymi konstrukcjami robotów. Jest jednak zasadnicza różnica pomiędzy nimi a nami: oni mieli tylko mity, a my mamy naukę i jedno z najważniejszych narzędzi w historii człowieka, czyli komputery.

Prześledźmy teraz w ekspresowym tempie początki rewolucji obliczeniowej, która doprowadziła nas do dzisiejszego stanu AI. Wszystko, co dziś mamy, opiera się na pomysłach dawnych pokoleń, dlatego właśnie tam zaczniemy.

Fragment obrazu – Szkoła Ateńska, Rafael

Wraz z pojawieniem się pierwszych filozofów, Grecy porzucili opisywanie świata przy pomocy mitów i zaczęli wyjaśniać świat przy pomocy rozumu. Niesamowite, że już w trzecim wieku p.n.e. Arystoteles wpadł na pomysł zastąpienia niewolników maszynami i opracował pierwszy w historii system logiki. To na nim, za ponad 2 tysiące lat, będzie się opierał kod binarny wykorzystywany w komputerach.

Na prawdziwe przełomy trzeba było trochę poczekać, bo aż do XVII wieku. Gdy skończył się marazm średniowiecza, różni myśliciele zaczęli sądzić, że rozumowanie człowieka jest bardzo podobne do obliczeń, co wprost nawiązywało do dawnych pomysłów Arystotelesa. Jednym z tych uczonych był

Gottfried von Leibniz

, który przyszedł na świat w 1646 roku. Otóż wpadł on na pomysł zrobienia urządzenia, które miało rozstrzygać co jest prawdą, a co nie. Jego idea opierała się na tym, że myśl ludzką można przedstawić w formie różnych obliczeń. Dlatego mając specjalnie skonstruowaną machinę, moglibyśmy rozstrzygnąć wszystkie możliwe spory – zamiast się kłócić, krzyknęlibyśmy „policzmy to!” i zakręcili wielką korbą. Leibniz napisał:

„Jedynym sposobem oczyszczenia naszego rozumowania jest sprawienie, aby było tak samo konkretne jak u matematyków, aby można było znaleźć błąd na pierwszy rzut oka. Wtedy dyskusje między różnymi ludźmi można sprowadzić do stwierdzenia: Policzmy to, aby bez większych korowodów zobaczyć, kto ma rację”.

To była (i jest zresztą nadal!) niesamowicie futurystyczna idea, ale Leibniz zajmował się też bardziej namacalnymi projektami. Uważał, że:

„Nie jest (…) rzeczą godną wykształconego człowieka, by tracić godziny pracując jak niewolnik nad obliczeniami, które mógłby wykonać każdy, gdyby użyto w tym celu maszyny”.

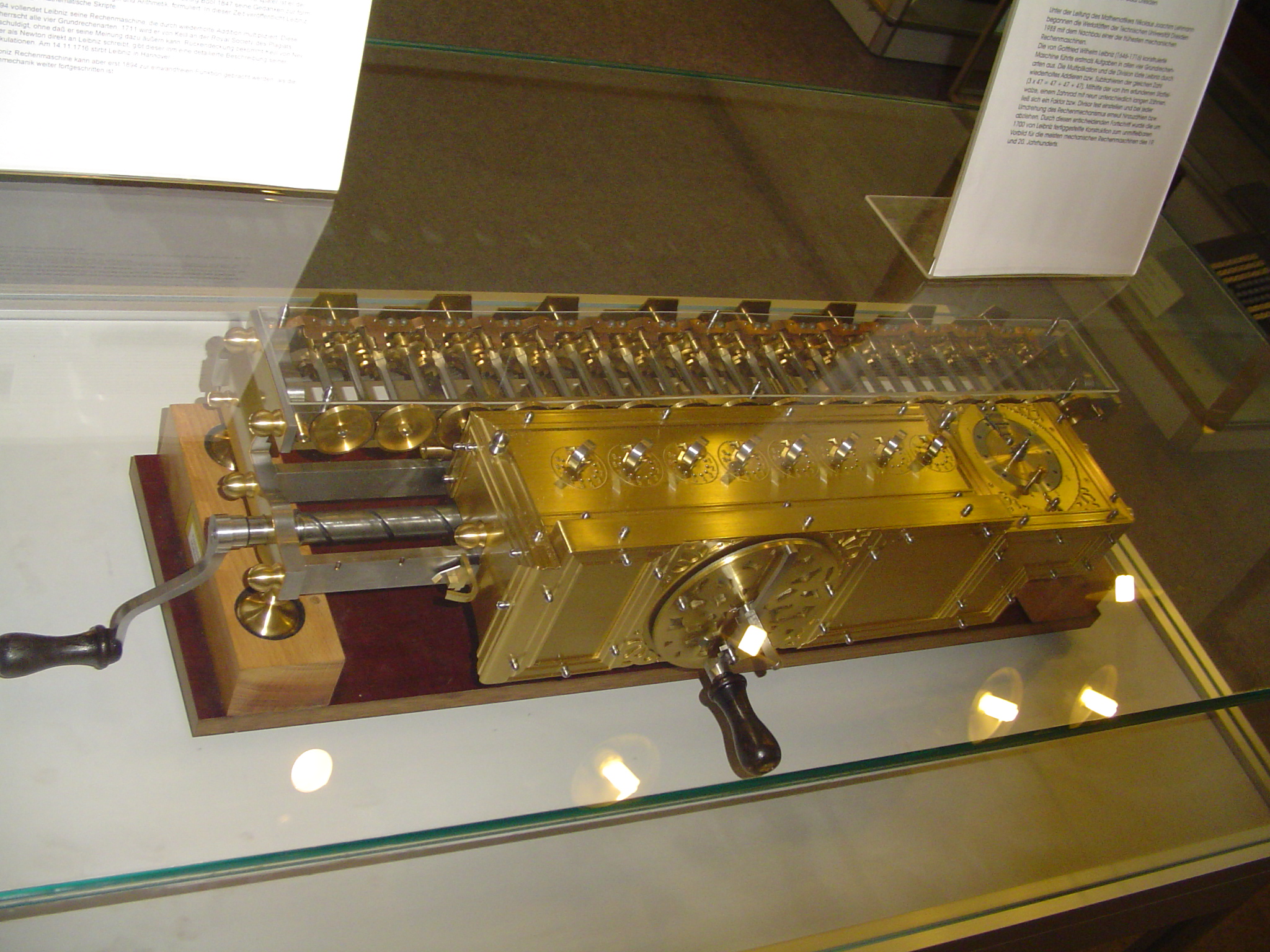

W związku z powyższym zaprojektował Maszyną Arytmetyczną, czyli gigantyczny kalkulator – daleki przodek dzisiejszych komputerów. Automat pozwalał dodawać, odejmować, przeprowadzać operacje ułamkowe i mnożyć, co było niebywałym osiągnięciem jak na tamte czasy. Ogromny mechanizm działał w oparciu o napędzany korbką metalowy cylinder, który wprawiał w ruch zębatki. Niestety Leibniz był kiepski w pracach praktycznych i nigdy nie udało mu się skonstruować niezawodnie działającego urządzenia. Jego pomysł na cylindrową zębatkę był jednak tak genialny, że wielu późniejszych innowatorów umieściło go w swoich maszynach liczących.

Maszyna Leibniza

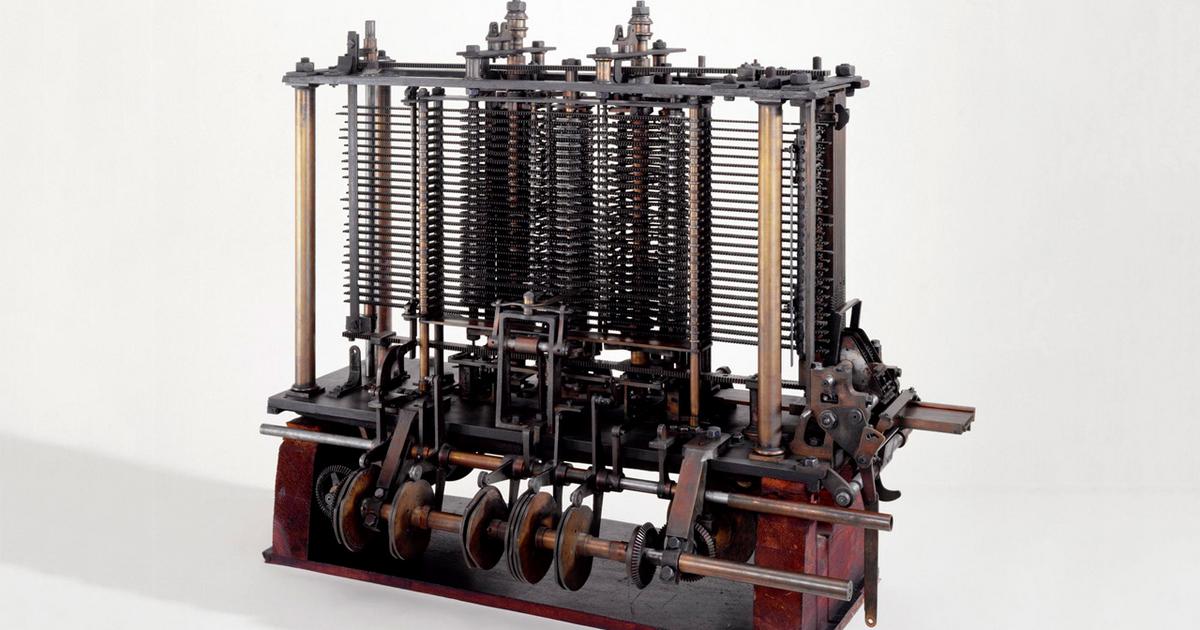

Musiało minąć 200 lat nim przyszedł na świat ojciec chrzestny dzisiejszych komputerów, czyli Charles Babbage . Ten urodzony w 1791 roku angielski matematyk już od najmłodszych lat był zainteresowany budową maszyn liczących. Inspirując się pracami Leibniza wpadł na pomysł rewolucyjnej konstrukcji, którą nazywał programowalną maszyną analityczną. Była to pierwsza na świecie maszyna, która dawała możliwość programowania, czyli wykonywania działań zgodnie z wrzuconymi do niej instrukcjami. Instrukcje miały być zapisywane na tzw. kartach dziurkowanych – dokładnie takich, jak w ówczesnym automatycznym krośnie tkackim.

Maszyna była cudem, ale tylko na papierze, ponieważ projektu Babbage niestety nie ukończył. Nie pozwalały mu na to ówczesne możliwości technologiczne. Mimo pionierskiego pomysłu nigdzie też się nie przebił, nawet w prasie popularnej. Udało mu się jednak znaleźć pewną młodą osobę, która była zafascynowana jego pomysłem. Była nią poetka i matematyczka Ada Lovelace. Postanowiła mu pomóc w nagłośnieniu projektu. Napisała wiele różnych publikacji na temat maszyny, a do wielu z nich dołączała również własne przemyślenia. Zwróciła m.in. uwagę na to, że maszyna analityczna może działać na elementach innych niż liczby i byłaby w stanie wykonywać nie tylko jedno zadanie, ale dowolne zadania o różnym stopniu skomplikowania. Uważała, że wystarczy tylko odpowiednio ją zaprogramować.

Część maszyny analitycznej

Lovelace przewidziała w ten sposób przyszłość, bo dzisiejsze komputery właśnie to robią – przetwarzają obrazy, dźwięki i wiele innych rzeczy. Wszystko zależy od wgranego programu. Przykładowo, jeżeli programista napisze odpowiedni program, to współczesny komputer może nawet zmieniać swój własny program, co stanowi podstawę uczenia się. A ta właściwość prowadzi nas do symulowania najbardziej tajemniczego zjawiska świata, czyli inteligencji, co wtedy wydawało się jeszcze dość kontrowersyjnym pomysłem. Zresztą sama Lovelace uważała, że maszyna nigdy nie będzie mogła wyjść poza zadany jej przez człowieka algorytm:

„Należy wystrzegać się przesadnych wyobrażeń co do rzeczywistych możliwości maszyny analitycznej. Maszyna analityczna nie ma pretensji do dawania początku czemukolwiek. Wykonuje wszystko, co jej polecimy.”

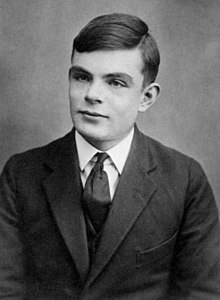

Wykluczyła tym samym możliwość istnienia inteligentnych maszyn. Z tym poglądem nie zgadzał się później Alan Turing, genialny informatyk XX wieku.

Przełomy mają miejsce dopiero wtedy, gdy ciekawe pomysły spotykają się z technologiami, które pozwolą na ich realizację. W innym przypadku lądują w szufladzie, jak miało to miejsce u Babbage’a. Co z tego, że wymyślił pierwszy na świecie komputer. Musiało minąć jeszcze wiele lat, zanim ludzkość dokonała wielu małych kroków i pojawiły się odpowiednie technologie pozwalające na jego budowę. Takim momentem, w którym pomysły spotkały się z technologiami, był niewątpliwie wiek XX. To był czas dynamicznych zmian i gwałtownego rozwoju nauki i technologii.

Wtedy też, bo w 1912 roku, urodził się Alan Turing – genialny matematyk, ojciec komputerów i sztucznej inteligencji. Już od najmłodszych lat był zafascynowany sztucznym rozumem i często zastanawiał się, w czym ludzki umysł różni się od rozumu maszyny. Temu zagadnieniu poświęcił zresztą resztę życia. Jako student Cambridge napisał artykuł o maszynie, która była teoretycznym modelem współczesnych komputerów – i to jeszcze zanim zbudowano pierwszy komputer. Przewidywał przyszłość, w której będą królowały myślące maszyny. W swoim artykule, który w 1950 roku opublikował w czasopiśmie Mind, próbował obalić wszystkie najistotniejsze argumenty, które podnoszono przeciwko możliwości stworzenia sztucznej inteligencji. Tam też odniósł się do zarzutów Ady Lovelace, która uważała, że komputer nie będzie mógł wyjść poza program zadany przez człowieka. Napisał:

„To nie znaczy, że w ogóle nie jest możliwe zbudowanie elektronicznego urządzenia, które będzie „myślało dla siebie” lub w którym, w terminach biologicznych, można by zainstalować odruch warunkowy, który stanowiłby podstawę „uczenia się”.

Alan Turing

Turing wierzył, że stworzenie prawdziwej myślącej maszyny będzie możliwe wtedy, gdy zostaną skonstruowane odpowiednio wydajne komputery. Tylko jak stwierdzimy to, że mamy do czynienia z myślącą, inteligentną maszyną? Wbrew pozorom nie jest to takie proste. Według Turinga pojęcia „inteligencja” i „myślenie” były mało precyzyjne, dlatego wymyślił praktyczny test, który miał odpowiedzieć na pytanie, czy maszyna myśli. Idea testu Turinga była bardzo prosta. Wyobraźmy sobie sędziego, który siedzi zamknięty w pokoju i rozmawia za pomocą terminalu tekstowego z maszyną i człowiekiem. Oczywiście sędzia nie wie, kto jest kim i stara się zgadnąć, zadając najróżniejsze pytania. Jeżeli sędzia nie potrafi odróżnić odpowiedzi człowieka od odpowiedzi maszyny, to sztuczna inteligencja przechodzi test i można wtedy powiedzieć, że maszyna myśli.

Test Turinga zainspirował kolejnych twórców do badań nad myślącymi maszynami. Mimo wielu wysiłków, do dzisiaj żaden algorytm nie zaliczył jeszcze długotrwałego, nieograniczonego tematycznie testu Turinga, co od dawna było wodą na młyn wielu krytyków. Zaliczał się do nich John Searle, który wiele lat po śmierci Turinga stwierdził, że pozytywne przejście testu nie świadczy o inteligencji maszyny, a prawdziwy rozum to coś więcej niż wykonywanie zwykłego algorytmu. Według niego komputery posługują się symbolami według narzuconych zasad, nie rozumiejąc ich znaczenia.

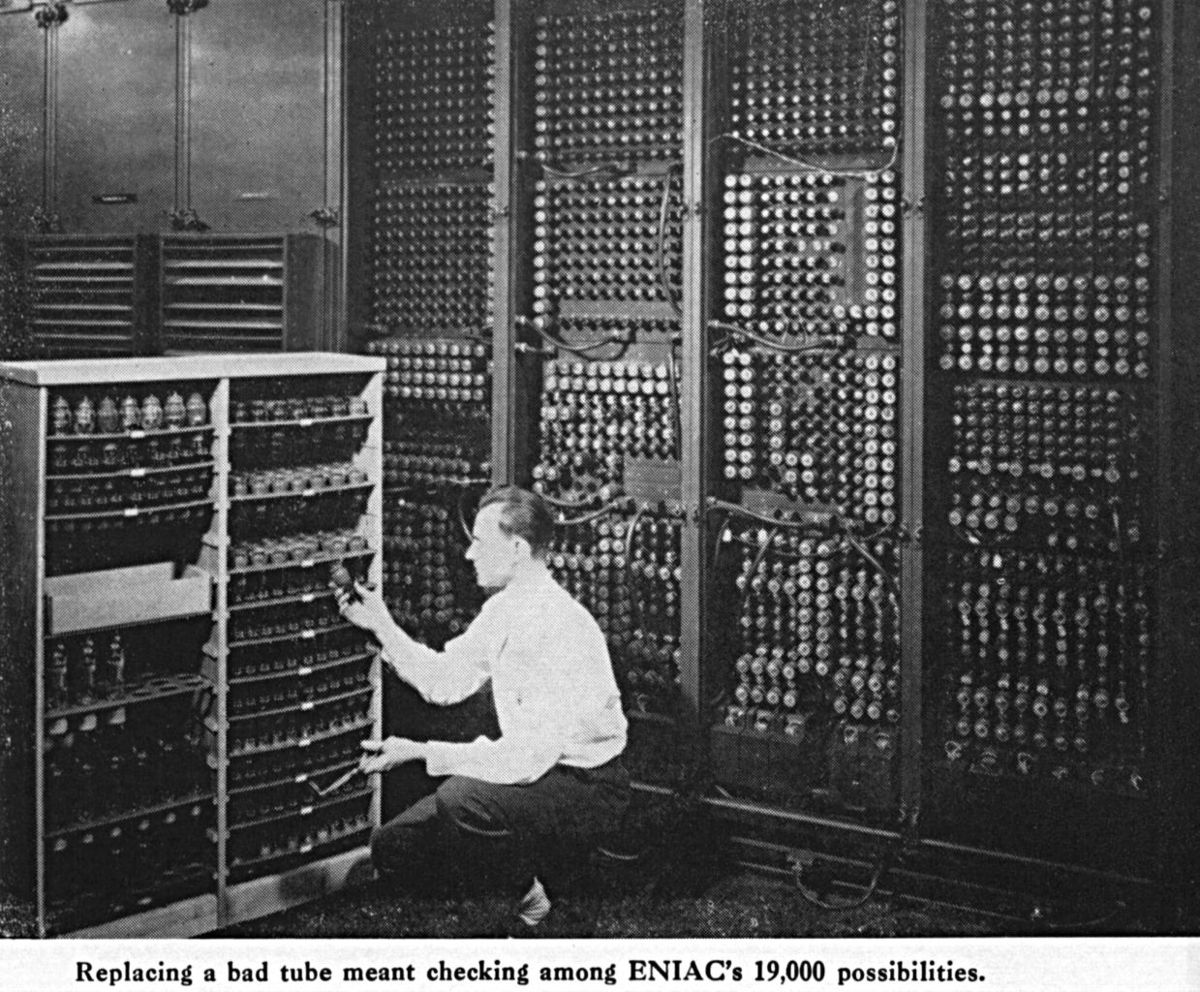

Alan Turing był świadkiem narodzin współczesnej informatyki. Wyścig zbrojeń wymagał coraz większej mocy obliczeniowej, która była w tamtym okresie na wagę złota. Powstawało więc coraz więcej komputerów do odszyfrowywania wiadomości wywiadowczych, obliczania zasięgu pocisków i budowania bomby atomowej. W 1933 roku niemiecki inżynier skonstruował maszynę liczącą Z3, która jako pierwsza wykorzystywała sterowanie elektrycznie przekaźniki. Był to komputer zerowej generacji. W 1940 roku powstał komputer pierwszej generacji, czyli cyfrowa maszyna ENIAC. Był oparty na ogromnych lampach elektronowych, które możecie kojarzyć ze starych radioodbiorników. Armia USA wykorzystywała go do obliczania zasięgu pocisków.

Maszyna licząca Z3

Lada moment miały się pojawić komputery drugiej generacji, czyli komputery zbudowane z krzemowych tranzystorów, które doprowadziły do niespotykanej nigdy wcześniej rewolucji. Tego jednak Turing już nie doczekał. W 1952 został skazany za naruszenie moralności publicznej za kontakty ze swoim kochankiem. Wskutek tego został odsunięty od badań związanych z komputerami i skierowano go na przymusową terapię hormonalną. Wytrzymał dwa lata, po czym z powodu wyobcowania załamał się psychicznie i popełnił samobójstwo. Zmarł w 1954. Dopiero w 2009 roku Wielka Brytania przeprosiła za całkowicie niesprawiedliwe potraktowanie Turinga, a w 2013 roku królowa brytyjska go ułaskawiła. Turing umarł chwilę przed początkiem ery maszyn cyfrowych. Ery, która już na zawsze zmieniła kształt naszego świata.

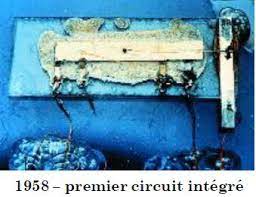

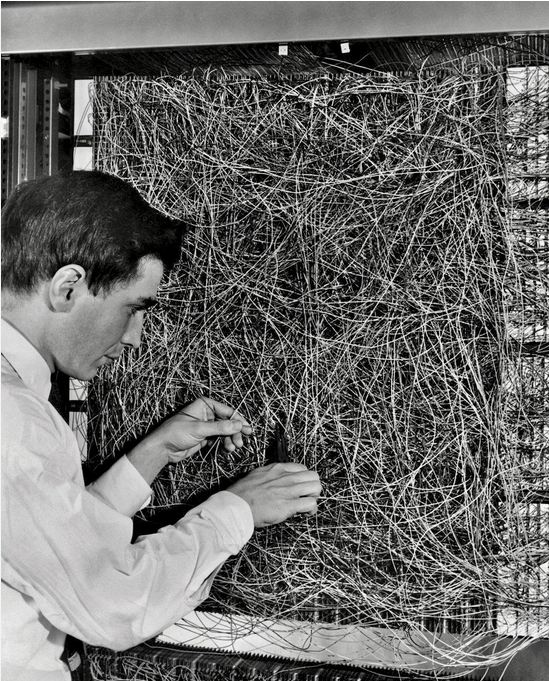

Pierwsze komputery – najważniejszy wynalazek człowieka, projektowano na papierze i montowano ręcznie. Na początku były przekaźniki, a potem lampa elektronowa – awaryjna, ręcznie robiona, na której opierały się komputery pierwszej generacji. Ale fizyka ciała stałego dokonuje zdumiewających odkryć i w 1947 amerykanie budują pierwszy tranzystor, jeden z kluczowych wynalazków ludzkości. Tranzystor był doskonalszy od lamp, bo nie zużywał tyle energii, rzadko się psuł i był setki tysięcy razy mniejszy. Przez kolejne lata udoskonalano jego konstrukcję, zmieniając np. materiał, z którego był wykonywany. Aż w końcu ktoś wpada na pomysł, aby na niewielkiej powierzchni umieścić wiele identycznych tranzystorów. Tak powstały pierwsze układy cyfrowe, kolejny etap ewolucji maszyn liczących.

Pierwszy tranzystor

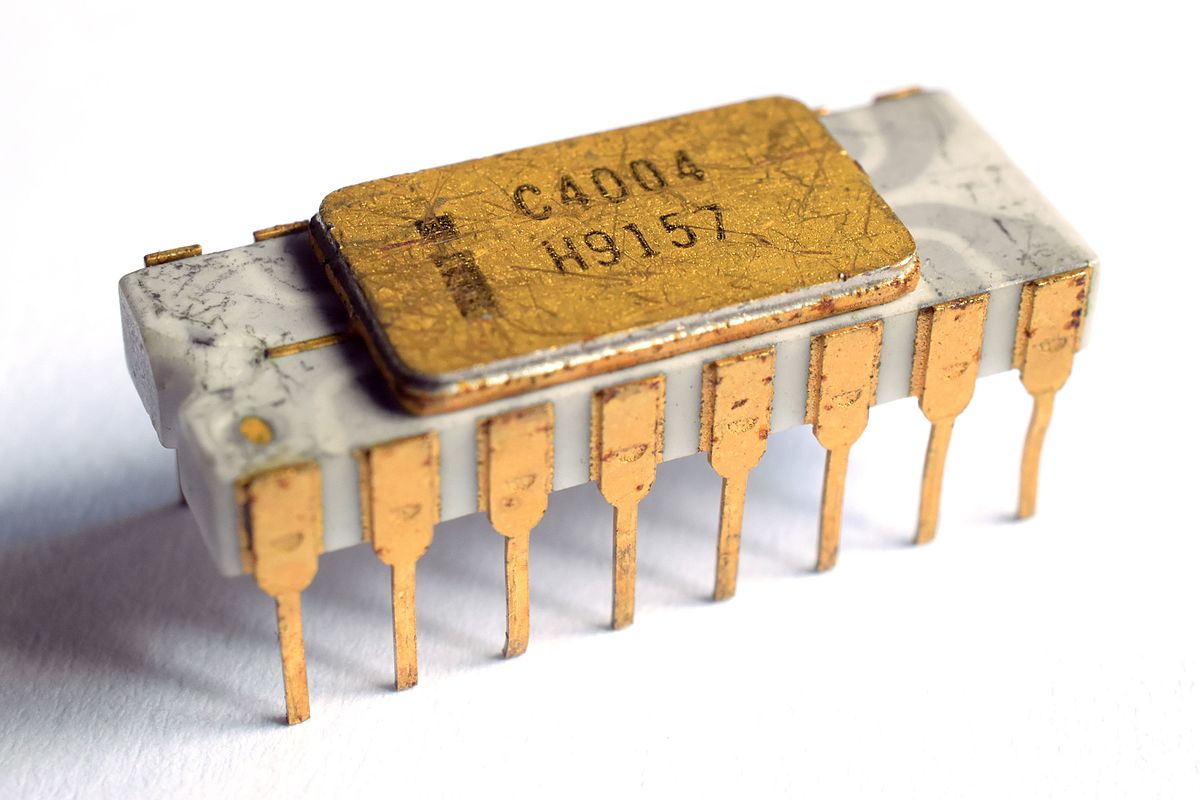

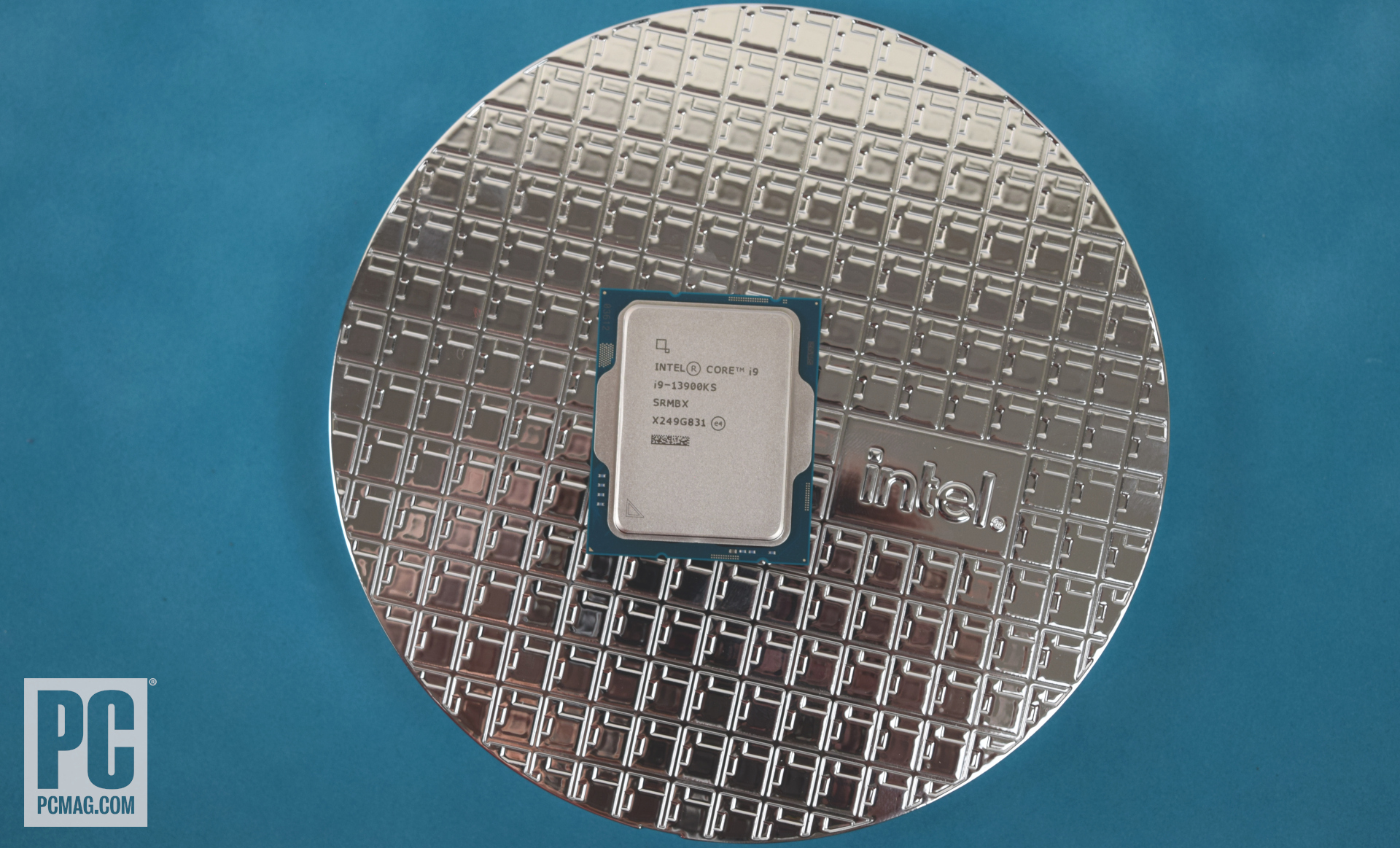

Gwałtownie zwiększała się liczba tranzystorów na tej niewielkiej płytce krzemu. W roku 1957 był jeden, w 1963 – osiem, w 1965 – szesnaście. A w 1977 roku już 256 tysięcy. Dziś mamy komputery mające więcej niż 3,000,000,000 tranzystorów. Jak to zawsze bywa w przyrodzie – każdy krok w rozwoju tworzył kolejny, występowało tutaj pewnego rodzaju dodatnie sprzężenie zwrotne. Dzięki już opracowanym układom scalonym i bazujących na nich komputerach, inżynierowie tworzyli kolejne generacje komputerów, które coraz bardziej automatyzowały ich pracę i automatycznie projektowały coraz większe fragmenty komputerów kolejnej generacji. Te zaś służyły do stworzenia kolejnych i kolejnych maszyn cyfrowych.

Dzięki zmniejszającym się tranzystorom komplikacja układów scalonych przyśpiesza niesamowicie szybko, co zauważył już w połowie lat 70. Gordon Moore, wymyślając Prawo Moore’a. Mówi ono, że liczba tranzystorów podwaja się w niemal równych odcinkach czasu, czyli – jak możemy powiedzieć używając matematycznego języka – rośnie wykładniczo.

Pierwszy układ scalony

Intel 4004

– pierwszy dostępny komercyjnie mikroprocesor

Intel Core i9-13900KS – współczesny procesor

Aby zademonstrować różnicę pomiędzy wzrostem wykładniczym a liniowym, przypomnijmy legendę o Sissa Nassir, czyli wynalazcy szachów. Mędrzec tak zachwycił swoją nową grą władcę, że ten obiecał mu nagrodę. Mędrzec miał sam ją wybrać, dlatego poprosił o ziarenka ryżu. Na pierwszym polu szachownicy miało być jedno ziarno, na drugim dwa, na trzecim cztery, na czwartym osiem, a na kolejnym znowu dwa razy więcej. Ponieważ władca myślał liniowo, bez wahania zgodził się na stawiane warunki. Jednak później okazało się, że w całych Indiach nie ma takiej ilości zboża, aby zapłacić mędrcowi. Na przedostatnim polu szachownicy władca musiałby bowiem umieścić aż 18 milionów trylionów ziaren ryżu. Oznaczałoby to, że trzeba byłoby obsiać ryżem aż trzy całe Ziemie! Taka jest potęga wzrostu wykładniczego, który ma również miejsce w świecie technologii.

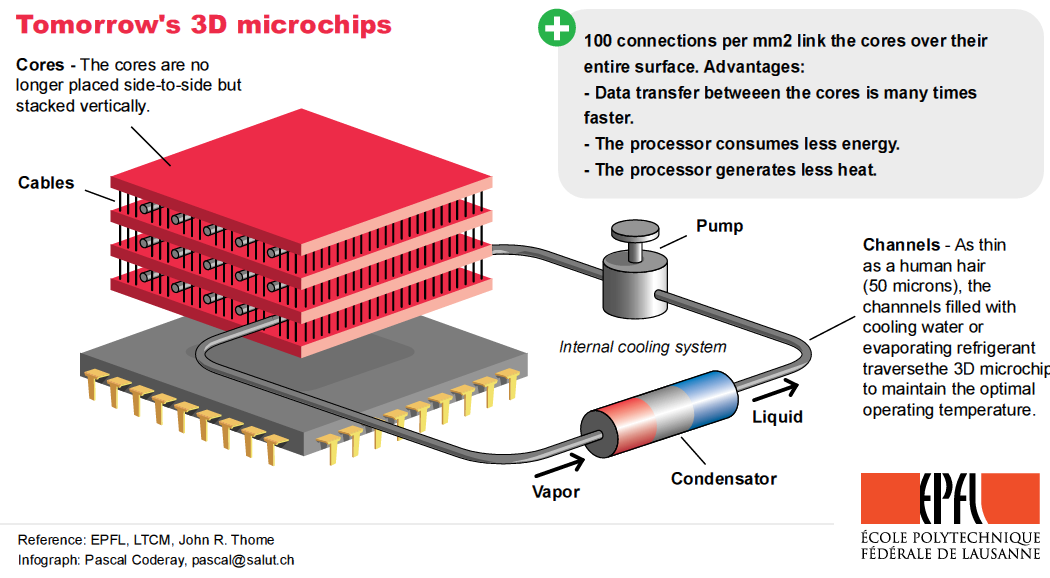

Oczywiście wykładnicze Prawo Moore’a nie jest wieczne i kiedyś

przestanie obowiązywać w odniesieniu do obecnej technologii procesorów

. Ale nawet jeśli za jakiś czas przyczyny fizyczne uniemożliwią dalszy wzrost szybkości i ilości pamięci w dzisiejszych komputerach to wszystko wskazuje na to, że nastąpi zmiana paradygmatu, przez co wzrost wykładniczy wciąż będzie miał miejsce. Zwiększymy moc korzystając z przetwarzania równoległego, przejdziemy np. na

trójwymiarowe molekularne przetwarzanie danych albo wykorzystamy do obliczeń coś innego niż elektrony

. Szczególnie dużym przełomem będą

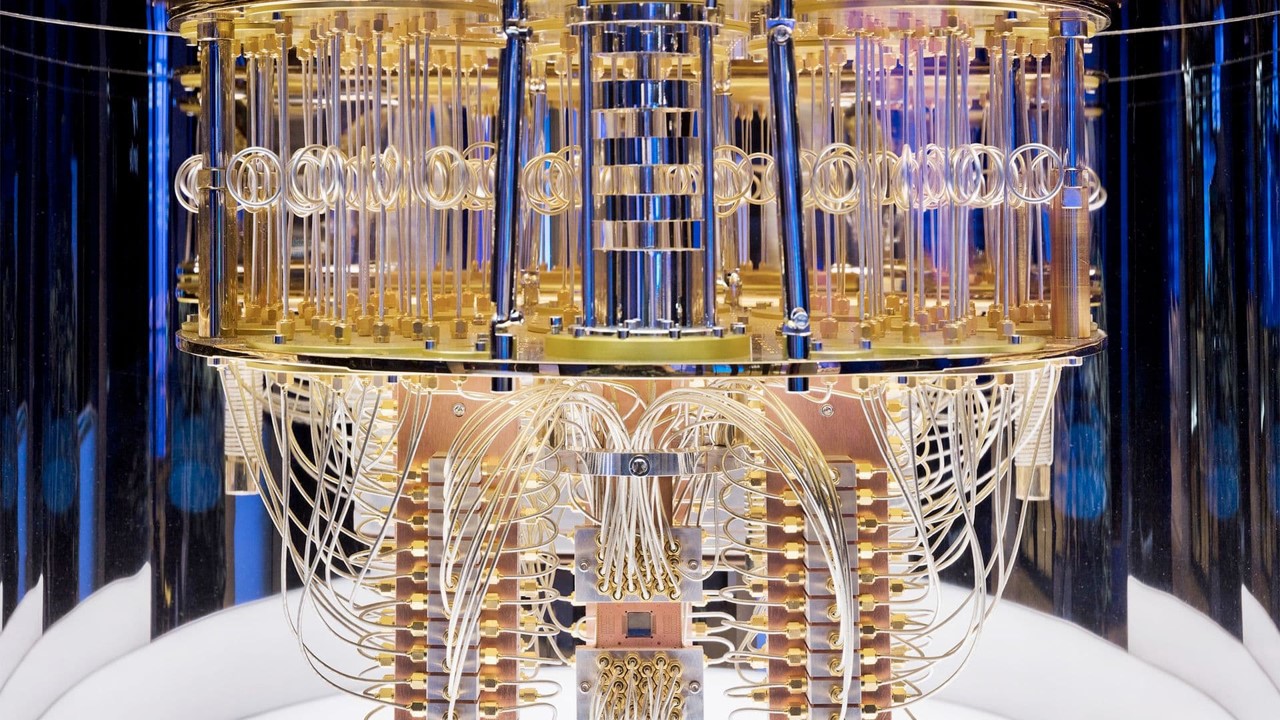

komputery kwantowe

, które wciąż znajdują się na etapie rozwoju wczesnych komputerów opartych na krzemie. Mimo że nie zastąpią tradycyjnych komputerów w wykonywaniu zwykłych obliczeń, znakomicie przydadzą się w wąskich dziedzinach, takich jak deszyfrowanie lub uczenie sztucznych sieci neuronowych w sztucznej inteligencji.

Komputer kwantowy IBM

Oczywiście wspomniane tendencje wykładnicze nie obejmują tylko szybkości procesorów – podobnie szybko rośnie objętość komputerowej pamięci i przybywa przetwarzanych informacji. A to wszystko przy niesamowicie szybko spadających kosztach. W ciągu ostatnich sześćdziesięciu lat pamięć komputerowa stawała się dwukrotnie tańsza co 2 lata, co daje ponad tysiąckrotne potanienie co 20 lat. Dyski twarde potaniały ponad 100 mln razy, a szybkie pamięci stały się tańsze o 10 bilionów razy przy wzroście pamięci o prawie 100 miliardów przez ostatnie 60 lat. Co parę lat obliczenia komputerowe stają się 2 razy tańsze. Od lat 60. komputer potaniał milion milionów milionów razy, przy wzroście mocy o milion milionów razy. Gdyby wszystko inne tak taniało, to za 1/100 grosza kupilibyśmy wszystkie towary i usługi wyprodukowane w tym roku na całej Ziemi. To dzięki tak szybko spadającemu kosztowi układów scalonych, na których opiera się cała współczesna elektronika, obliczenia są teraz wszechobecne.

Po zakończeniu II wojny światowej ludzkość ochłonęła, a komputery stawały się coraz bardziej dostępne i pojawiały się na wielu uniwersytetach. Na początku były ogromnymi konstrukcjami, zajmowały specjalne klimatyzowane sale i miały moc mniejszą niż dzisiejszy smartwatch. Z czasem ich możliwości stopniowo rosły, a wielu naukowców zaczęło się zastanawiać, czy dałoby się przy ich pomocy naśladować procesy ludzkiego rozumowania. Nawet widoczne to było w nazewnictwie ówczesnych komputerów – nazywane były mózgami elektronowymi, co podkreślało ich związek z ludzkim mózgiem. Panujący wtedy optymizm doprowadził do zorganizowania przez Johna McCarthy’ego dwumiesięcznej konferencji poświęconej tematyce myślących maszyn. Odbyła się w 1956 roku w Dartmouth College i to właśnie tam został ukuty termin

Sztuczna Inteligencja.

Przez prawie 2 miesiące największe umysły głowiły się nad tym, jak matematycznie opisać różne aspekty ludzkiej inteligencji, aby można było ją symulować na komputerach. Naukowcy doszli do wniosku, że w ciągu 20 lat nastąpi ogromny przełom w dziedzinie sztucznej inteligencji. Później oczywiście okazało się, że jest to niemożliwe, bo istniejący wtedy sprzęt był jeszcze zbyt słaby. Jednak prace nad AI były ciągle prowadzone i małymi kroczkami budowaliśmy coraz bardziej „inteligentne” maszyny.

Próbę zbudowania elektronicznego mózgu jako pierwszy podjął

Frank Rosenblatt

w 1958 roku. Po zapoznaniu się z ówczesną wiedzą dotyczącą funkcjonowania układu nerwowego człowieka, postanowił zmontować ogromne, elektryczno-mechaniczne urządzenie. Było złożone z 256 sztucznych neuronów, czyli bardzo uproszczonych odpowiedników ludzkich komórek nerwowych. Po uruchomieniu machiny wszyscy byli w szoku, bo okazało się, że ta prosta sieć neuronowa potrafiła skutecznie rozpoznawać pokazywane jej obrazki. Gdy pokazano przed jej prymitywną kamerą trójkąt, zapalała się lampka z napisem „trójkąt”. Gdy podsunięto kartkę z narysowanym kwadratem, sieć odpowiadała – „kwadrat”. Podobnie było w przypadku innych figur geometrycznych. W zdumienie wprawiał też fakt, że połączenia pomiędzy poszczególnymi neuronami powstały w sposób losowy, bez żadnego planu, a mimo tego maszyna działała! Było to wręcz pierwsze zbudowane bez planu urządzenie, które działało! Oczywiście tajemnica tkwiła w zdolności uczenia się, dzięki której sieć neuronowa bez udziału człowieka mogła przeorganizować swoje połączenia w swoim elektronicznym mózgu. Maszyna Rosenblatta była protoplastą dzisiejszych sztucznych sieci neuronowych, czyli najpopularniejszej obecnie techniki sztucznej inteligencji. Dzisiaj te sieci realizujemy głównie w postaci programów na komputerze, jednak pojawiają się projekty, które bezpośrednio nawiązują do wynalazku Rosenblata. Chodzi w nich o sprzętowe odtworzenie sieci neuronowych

w postaci neuromorficznych chipów.

Rosenblatt – pierwszy elektroniczny model mózgu

Dyskusja nad sztuczną inteligencją uległa ponownie ożywieniu w 1979 roku. Komputery były już wtedy oparte na układach scalonych, a na rynku można było sobie kupić komputer domowy Apple II. Wielu badaczy prowadziło wtedy eksperymenty nad programami grającymi w różne gry. I tak na Carnegie-Mellon University stworzono program o nazwie BKG 9.8, który wygrał z mistrzem świata w tryktraka, czyli popularną grę planszową. Wydarzenie to odbiło się szerokim echem w wielu mediach na całym świecie, bo po raz pierwszy człowiek został pokonany przez maszynę. Z biegiem lat komputery stawały się coraz szybsze, a my przegrywaliśmy z nimi w kolejne gry. W 1995 roku komputer wygrał z mistrzem świata w warcaby, a dwa lata później komputer szachowy IBM Deep Blue pokonał szachowego arcymistrza, Garriego Kasparowa. Po przegranym turnieju Kasparow stwierdził, że w czasie gry poczuł dużą inteligencję i kreatywność maszyny.

W 2011 zapadł się kolejny bastion, gdzie panował człowiek, bo komputery nauczyły się rozumienia języka naturalnego, czyli naszego języka, którym posługujemy się na co dzień. Komputer IBM Watson zagrał w amerykańską wersję teleturnieju Va banque i zwyciężył z dwoma najlepszymi graczami. Gra Va banque polega na tym, że trzeba odpowiadać na pytania prowadzącego formując własne pytania.

IBM Watson w teleturnieju Va banque (Jeopardy)

A tak wyglądały odpowiedzi Watsona:

Pytanie prowadzącego:

W wąwozie Olduvai w 1959 roku ona i jej mąż Lewis znaleźli czaszkę Australopithecus boisei sprzed 1,75 miliona lat.

Odpowiedź Watsona:

Kim jest Mary Leakey?

Pytanie prowadzącego:

Rodzice tego 52 gubernatora Nowego Jorku wyemigrowali do Stanów Zjednoczonych z Salerno we Włoszech.

Odpowiedź Watsona:

Kim jest Mario Cuomo?

Pytanie prowadzącego:

Puchar Kalkuty, nadawany drużynom rugby od 1979 roku, ma na szczycie słonia i jest wykonany ze stopionych monet tej waluty.

Odpowiedź Watsona:

Co to jest rupia?

Po raz kolejny o sztucznej inteligencji zrobiło się głośno, gdy w 2016 roku komputer wygrał w grę Go z arcymistrzem Lee Sedolem. Gra ta ma niesamowitą złożoność – możliwych ruchów niż jest atomów we Wszechświecie. Krytycy od dawna uważali, że wygrana komputera w przypadku tej gry jest niemożliwa. A tu proszę – algorytm Alpha Go wygrywa z człowiekiem, ucząc się grania w tę grę na bazie tysięcy historycznych gier profesjonalistów i amatorów. Kolejna zaś wersja Alpha Go – Alpha Go Zero, która powstała rok później, pokonała poprzedni algorytm w stosunku 100:0. Potrzebowała do tego zaledwie 3 dni nauki, rywalizując wyłącznie sama ze sobą i nie korzystając z żadnej wiedzy dostarczonej przez człowieka. Natomiast po 40 dniach nauki odkryła wszystkie zasady i posiadła całą wiedzę ludzkości na temat tej gry, którą ludzie zdobywali przez ponad 3 tysiące lat.

Pojedynek Lee Sedol vs AlphaGo

Po grze Go przyszedł czas na Pokera. W 2017 roku sztuczna inteligencja wygrała z najlepszymi graczami w tę grę. Nauczyła się orientować w położeniu kart, ale również – co ciekawe – analizować emocje graczy.

Natomiast w 2020 roku mieliśmy kolejny przełom. Firma DeepMind opracowała program, który potrafi grać na poziomie ludzkim w kilkadziesiąt klasycznych gier na Atari. Program uczył się na własnych błędach, grając sam ze sobą i obserwując piksele na ekranie komputera – dokładnie w taki sam sposób, jak robi to człowiek. W Internecie jest dużo ciekawych filmików pokazujących, jak AI uczy się grania. Na początku popełnia wiele błędów, robi całkowicie bezmyślne ruchy. Jednak po jakimś czasie wpada na coraz lepsze strategie, aż w końcu gra lepiej niż najlepsi gracze. Potrafi też wymyślać różne drogi na skróty, starając się przechytrzyć wirtualnych przeciwników w grze. Zupełnie jak człowiek.

Gry są bardzo dobrym wskaźnikiem rozwoju sztucznej inteligencji.

Często wymagają planowania, a nawet abstrakcyjnego myślenia. Zresztą te same metody AI co w grach mogą być później stosowane w zupełnie innych dziedzinach. Możemy je wykorzystać na przykład do rozwiązywania najtrudniejszych problemów w nauce – od projektowania nowych leków po modelowanie zmian klimatycznych.

Dzisiejsza AI potrafi już komponować piosenki, pisać scenariusze filmowe i artykuły prasowe, malować obrazy, prowadzić samochody i wykonywać prace polowe. Nadzoruje systemy w inteligentnych miastach, fabrykach i domach. Posiadamy potężne algorytmy AI, które diagnozują choroby, opisują zdjęcia przy pomocy słów i prowadzą autonomiczne samochody. Powstają też systemy służące do obsługi klienta, takie jak Soul Machines, czyli cechujące się empatią awatary, które wyglądają jak prawdziwi ludzie. Mogą one zastąpić w 100% ludzi w obsłudze klienta i osiągają 40% współczynnik rozwiązanych problemów bez udziału człowieka.

Rozwój modeli typu GPT-4 sprawił, że dzisiejsze komputery mogą odpowiadać na różnie pytania, symulować postaci historyczne, rozwiązywać łamigłówki i odpowiadać na zagadki słowne lub samodzielnie pisać programy komputerowe na bazie naszego słownego opisu, co program ma robić. Firmy technologiczne projektują w swoich laboratoriach roboty, które będą przypominały nieliniowce skończone z Opowieści o pilocie Pirxie Lema, są rozwijane latające samochody sterowane przez sztuczną inteligencję, a także medyczne systemy wczesnego ostrzegania, które zapewnią nam długowieczność. Dzięki AI eksplorujemy również powierzchnię Marsa i utrzymujemy przy życiu kosmonautów.

Często nie zauważamy, że sztuczna inteligencja jest obecna w tak wielu dziedzinach naszego życia. A przecież codziennie dobiera nam reklamy na Facebooku, wytycza optymalną trasę w GPS, rekomenduje piosenki i filmy w Spotify i na Netflixie, rozpoznaje mowę, analizuje zmiany na giełdzie, filtruje wiadomości w skrzynce e-mail i robi wiele, wiele innych rzeczy. Świat jest przesiąknięty algorytmami sztucznej inteligencji, o czym powiemy jeszcze w kolejnych odcinkach podcastu, skupiając się na najważniejszych zastosowaniach.

Szczególnie duży postęp jest widoczny w dziedzinie rozumienia języka naturalnego i tłumaczenia tekstów na różne języki. Anthony Oettinger, pionier tłumaczenia maszynowego na Harvardzie, opowiedział kiedyś historię o wczesnych systemach tłumaczeniowych, które były wykorzystywane w amerykańskich agencjach wywiadowczych podczas zimnej wojny. Amerykańskim wojskowym zależało na szybkim tłumaczenia tekstów z rosyjskiego na angielski, więc stworzyli specjalne tłumacze komputerowe. Gdy wrzucono na wejście takiego programu zdanie

„the spirit is willing but the flesh is weak”

(duch ochoczy, ale ciało mdłe) i przetłumaczono na język rosyjski, a następnie ponownie przełożono z rosyjskiego na angielski, otrzymano zdanie:

„the vodka is good, but the meat is rotten”

(wódka jest dobra, ale mięso się zepsuło). Od tamtej pory, dzięki nowoczesnym metodom sztucznej inteligencji, jakość tłumaczenia znacznie się poprawiła, a systemy coraz lepiej radzą sobie z gramatyką, semantyką i składnią wielu języków. Wystarczy sobie odpalić tłumacza Google na smartfonie i przeprowadzić własne testy, choćby na tym zdaniu.

Sztuczna inteligencja jest obecnie w tendencji wzrostowej.

Rządy przeznaczają miliony dolarów na rozwój przeróżnych metod sztucznej inteligencji. Rynek wzrósł z 420 mln w 2014 do ponad 5,05 mld dolarów w 2020 roku. W sektorze nowych technologii obserwujemy wręcz turboprzyśpieszenie, bo razem ze sztuczną inteligencją rozwijają się też inne technologie wykładnicze. Zaliczamy do nich robotykę, neuromorficzne architektury, biotechnologie i nanotechnologie, druk 3D, Internet rzeczy i Internet ciał, neuronauki, wirtualną i rozszerzoną rzeczywistość, chmury obliczeniowe i najróżniejsze metody cybernetyki.

W najbliższych latach doczekamy kolejnych przełomów. Komputery kwantowe już dziś mają 127 kubiów, czyli kwantowych bitów. 100 kubitów pozwala wykonać obliczenia niemożliwe do wykonania w ciągu czasu istnienia Wszechświata na tradycyjnych superkomputerach. Jeszcze dzisiejsze superkomputery wykorzystują te kubity w bardzo wąskich zadaniach, ale to kwestia czasu, kiedy ich możliwości będą większe.

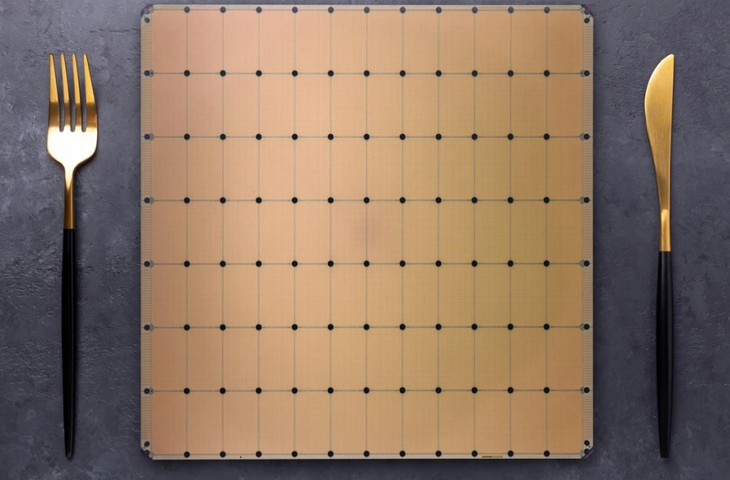

W 2021 roku powstał chip Cerebras CS-2, który pozwala tworzyć modele sztucznej inteligencji posiadające aż 120 bilionów parametrów. Przewyższa to 100 bilionów synaps obecnych w naszych mózgach. Rozwijają się też komputery neuromorficzne, czyli przypominające pod względem budowy to, co mamy w mózgu. Już dziś chipy neuromorficzne typu IBM TrueNorth lub Intel Loihi 2 posiadają 1 mln sztucznych neuronów i pracują 5000 razy szybciej niż biologiczne komórki. Ściana takich chipów pozwala osiągnąć liczebność neuronów taką jak w mózgu niedźwiedzia brunatnego. I to mniejszym zużyciu energii niż suszarka lub toster. Oczywiście sztuczne neurony są nadal sporym uproszczeniem tych biologicznych. Lecz projekty typu Human Brain Project dążą do dokładnego zasymulowania ludzkiego mózgu w komputerze, co może dać początek świadomości wytworzonej w maszynie.

Cerebras CS-2

Postęp jest przeogromny, co już kiedyś zauważył Stanisław Lem:

Postarajmy się teraz odpowiedzieć na pytanie, czym jest współczesna sztuczna inteligencja. Na pewno nie jest jeszcze Terminatorem lub inną maszyną z filmów s-f. Otóż nie posiadamy jeszcze tzw. silnej sztucznej inteligencji, czyli AI na poziomie ludzkim lub ponadludzkim. To, co obecnie mamy, jest zbiorem niepowiązanych ze sobą metod programistycznych, które sprawdzają się w wąskich zastosowaniach.

Dobrą metaforą obecnego stanu AI jest archipelag wysp . Ogromny archipelag, składający się z wielu, oddzielonych od siebie wysepek. Te wysepki to są różne metody sztucznej inteligencji. Jest ich sporo, mamy np. różnorakie metody symboliczne, algorytmy genetyczne, algorytmy mrówkowe, logikę rozmytą, czy też np. sztuczne sieci neuronowe. Z tych metod korzystamy w zadaniach, które nie są efektywnie algorytmizowalne. Czyli jeśli nie wiemy, jak napisać program, który rozwiązuje jakieś trudne zadanie, to bierzemy wybraną metodę sztucznej inteligencji, która w danym zadaniu sprawdzi się najlepiej. Takich problemów efektywnie niealgorytmizowalnych jest bardzo dużo, to np. diagnostyka medyczna, działania twórcze, sterowanie robotami, rozpoznawanie pisma odręcznego, rozpoznawanie mowy i twarzy, czy też prowadzenie samochodu autonomicznego.

Obecnie największym rozgłosem cieszy się metoda zwana sztucznymi sieciami neuronowymi. W sztucznych sieciach neuronowych chodzi o budowanie czegoś na obraz i podobieństwo naszego szekspirowskiego kruchego domu duszy, czyli mózgu. Rzecz jasna w ogromnym uproszczeniu… Sieć taka składa się ze sztucznych neuronów, które są bardzo uproszczoną wersją szarych komórek w naszych mózgach. Z jednego neuronu nie byłoby zbyt wielkiego pożytku, dlatego łączymy je w sieci składające się z wielu takich elementów. Później symulujemy je w komputerze.

Kiedyś sieci były małe i płytkie. Ale 9 lat temu nastąpił pewien przełom w tej dziedzinie, któremu zawdzięczamy tak duże zainteresowanie sztuczną inteligencją. Powstały nowe typy głębokich sieci.

Z roku na rok stawały się coraz głębsze. Rozkwitła dziedzina zwana głębokim uczeniem, a skuteczność głębokich sieci neuronowych przyczyniła się w ogromnej mierze do ostatnich sukcesów AI.